Tekniken för ansiktsigenkänning och dess förmågor har vuxit långt bortom vår fantasi ända sedan nya algoritmer för att förstärka denna teknik inom brottsbekämpning har blivit framträdande. För närvarande används teknik för ansiktsigenkänning av brottsbekämpande styrkor på de lägsta nivåerna av datainsamlingsprocesser för att identifiera brottslingar i trånga sammankomster. Tekniken använder bilder från CCTV-kameror på offentliga platser och gator och kör sedan insamlad data mot byråarkiv för att upptäcka ett ansikte som är eftersökt för brott.

Denna teknik har ytterligare inbäddats i de minsta prylarna, inklusive mobiltelefoner och smarta bärbara enheter. Därför skyddar det inte bara dig på gatan utan har också för avsikt att skydda din personliga information som lagras på dina smarta enheter. Att använda "ansiktsavtryck" för marknadsföring och reklam har blivit vanligt i den moderna tidsåldern av kampanjer för sociala medier. Och sedan finns det privat övervakning i gallerior, butiker, etc.

Ur detta perspektiv kan man snabbt peka på de obestridliga fördelarna med teknik för ansiktsigenkänning. Men det har också granskats för det hot det utgör mot användarnas integritet, dataskydd och naturligtvis transparens mellan lagen och allmänheten. Det är bra att vara medveten om både fördelar och nackdelar med en sådan invasiv teknik. Ändå finns det ytterligare en nackdel med tekniken för ansiktsigenkänning, som folk verkar ignorera, och det är rasprofilering och rasdiskriminering .

I det här stycket tittar vi på hur den här tekniken främjar rasfördomar och diskriminering och hur allvarliga återverkningarna av sådan invasiv teknologi är.

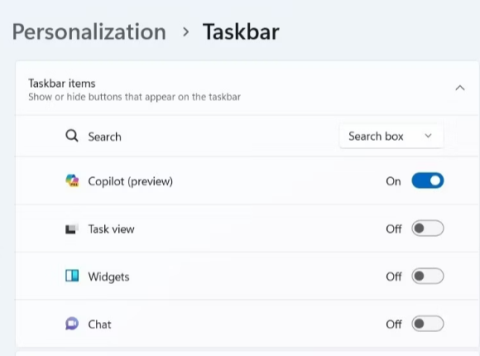

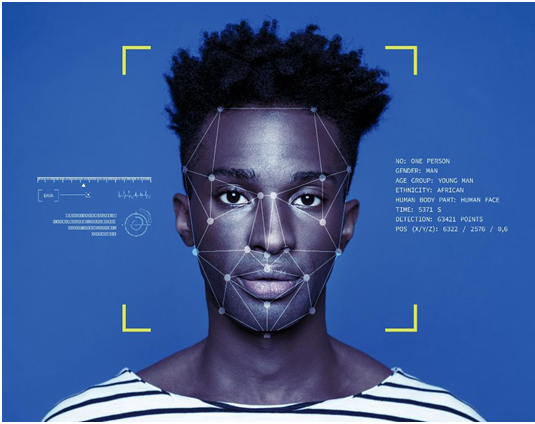

Hur fungerar ansiktsigenkänning?

Bildkälla: National Post

Steg 1: En bild på dig är tagen från en kamera, ditt konto, e-post, etc. Det är antingen en rak profilbild eller en slumpmässig bild i en folkmassa.

Steg 2: Ansiktsigenkänningsprogramvaran kör ditt ansikte genom en databas med lagrade ansiktsavtryck. Ansiktsavtrycket samlas in via geometrisk spårning av ditt ansikte.

Steg 3: En matchningsprocent av din bild mot alla kända ansiktsavtryck produceras med hjälp av en algoritm över vilken en bestämning görs.

Automation Bias: En av många brister i teknik för ansiktsigenkänning

Automation Bias eller Machine Bias hänvisar till scenariot där en maskinalgoritm uppvisar en viss bias i kalibreringen av indata, vilket ger en ogynnsam utdata. Detta händer när det finns ett fel i algoritmkoden, brist på lagrade datamängder för kalibrering, felaktiga ingångsvärden eller överdriven indata, vilket är bortom maskinernas styrka att kalibrera.

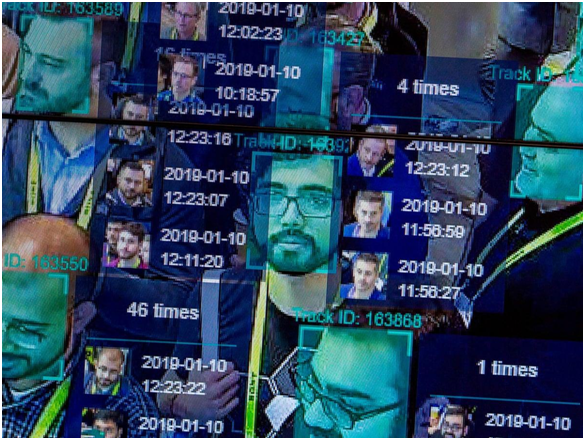

Hur rasprofilering går med allt detta?

Bildkälla: The Guardian

Låt oss börja med en uråldrig händelse som vid den tiden ansågs obetydlig. År 2001 använde Tampa City ansiktsigenkänningsprogram för övervakning av den fullsatta staden när turister översvämmade stadens gator på grund av Super Bowl 2001. Enligt en rapport från New York Times identifierade programvaran 19 personer som förmodligen hade utestående teckningsoptioner mot dem; dock gjordes inga arresteringar eftersom stadionens infrastruktur gjorde det omöjligt att komma till de identifierade gärningsmännen bland en överväldigande folkmassa.

Även om tecknen på rasprofilering inte sågs någonstans i det här specifika fallet, var det första gången övervakningstekniker ställdes upp mot kränkningar av medborgerliga friheter och individers integritet. Under de kommande åren gav Tampa-polisen upp dessa övervakningssystem med hänvisning till opålitliga resultat.

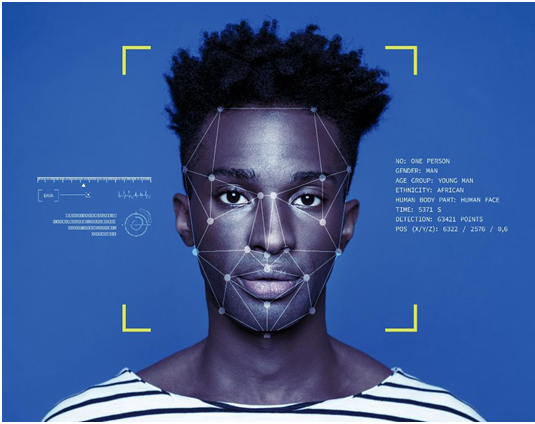

Bildkälla: ICO

Snabbspolning framåt till ett något nyare scenario, rapporterade Ali Breland för The Guardian , angående en arrestering av Willie Lynch, en svart man anklagad för att vara en ökänd knarkhandlare i Brentwood-området, övervägande en stadsdel med färgade människor. Det enda beviset mot Lynch var hans bilder på en mobil, som kördes mot en polisdatabas innan polisen fastställde honom som den skyldige. Lynch dömdes i åtta år, som nu har överklagat fällandet. Oavsett om han var den påstådda återförsäljaren eller inte, väcker det oundvikligen oro över huruvida endast ett maskinbaserat resultat är tillräckligt för att upprätthålla fällande dom för någon som är under utredning?

Under 2019, som rapporterats av Tom Perkins för The Guardian , hittades polisen i Detroit med ansiktsigenkänning för att göra arresteringar som påstås ha gjorts under de senaste två åren. Detroit är en plats där mer än 80 % av befolkningen är svarta. Ett uttalande från en svart medlem från Detroit Police Commission väckte farhågor mot bruket. Han sa att svarta människor har ett gemensamt ansiktsdrag som äventyrar systemets algoritm, och kallar detta "teknorasism".

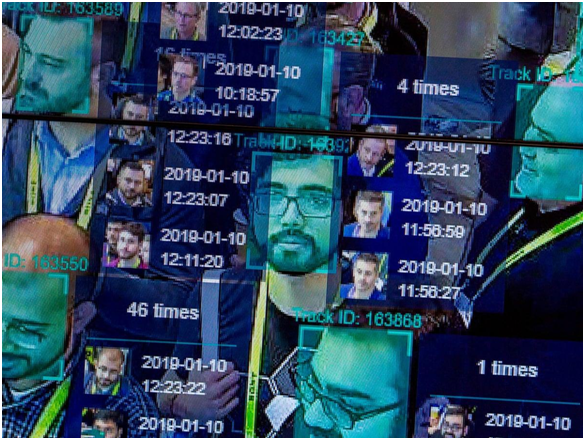

Bildkälla: Vox

I en forskning från 2019 för Journal of Information Communication and Ethics Society, av Fabio Bacchini och Ludovica Lorusso, fann man att dessa biometriska och ansiktsigenkänningssystem inte är 100 % tillförlitliga för brottsbekämpning. Dessutom var rasdiskriminering en negativ inverkan på alla sådana system, vilket har ytterligare omvända samhälleliga konsekvenser. Studien riktade sig särskilt till västerländska samhällen, där sådana system används i stor utsträckning för övervakning.

Det här är bara tre av många sådana exempel där rasskillnader orsakade av system för ansiktsigenkänning har kommit fram i ljuset. Men varför är dessa system så inkompetenta trots en sådan växande noggrannhet i algoritmiska kodningsuppgraderingar inom teknik.

White Supremacy in the Western States: A White-Dominant Tech Industry

Under 2014 visade sig en majoritet av teknikföretagen, inklusive jätten Apple Inc., anställa mestadels vita, manliga anställda. I Apple var 55 % av de anställda vita, och på samma sätt omfattade Apples ledarskap 63 % av de vita anställda. De företag som delade liknande mångfaldsrapporter var även Facebook , Google och Twitter. Fem år senare avslöjade en rapport i Wired att det hade skett minimal förbättring av dessa siffror.

Medan Facebook visade en anständig förbättring i siffror, var Apples andel svarta tekniska arbetare oförändrad på bara 6% av den totala arbetsstyrkan. Amazon var den enda organisationen som registrerade 42 % svarta eller latinamerikanska arbetare på sina kontor i USA.

Vad betyder denna statistik? I USA är de flesta kodarna, som är tilldelade stora projekt som att designa algoritmer för övervakningssystem, vita. Det är dessa personer som fattar de viktigaste besluten angående en produkt eller tjänst som ska lanseras/avtäckas av ett företag. Och därför är det deras perspektiv, förhållningssätt och tankeprocesser som går i den slutliga skapelsen. Detta innebär inte att vita människor är rasister och medvetet har utformat sådana övervakningssystem . NEJ!

Bildkälla: Forbes

När en vit kille designar en ansiktsigenkänningsalgoritm och bara har vita kollegor som konsulterar/hjälper honom, tar de inte hänsyn till personer av annan färgs ansiktsdrag innan de slutför koden. Eftersom vita ingenjörer dominerar teknikindustrin, skapas och kalibreras även dataarkiven som används för att förbereda den initiala koden av vita tekniker. Således skapas själva koden med en bias i dess kärnberäkningsalgoritm, vilket resulterar i dessa rasmässiga skillnader i övervakningsresultat.

Koden lär sig helt enkelt vad vita människor förkroppsligar i den. Det finns inget perspektiv eller bidrag från någon person av annan färg.

Kalibreringsproblemen

Amerikansk brottsbekämpning är starkt beroende av övervakning och dataspårning. Det har förekommit många tillfällen där visselblåsare avdrev information om obehörig övervakning av civila. Edward Snowdens avslöjande av NSA:s illegala övervakning är ett sådant exempel.

Bildkälla: CBS Local

Dessa övervakningsprogram stöds av ansiktsavtryck och annan personlig information från miljontals medborgare. Om vi bara betraktar ansiktsavtryck, finns det miljontals amerikaner som öppet delar bilder på sociala medieplattformar. Sedan finns det CCTV-kameror på alla gator i landet som erbjuder livebilder av hundratusentals förbipasserande. För närvarande finns det cirka 117 miljoner bilder i polisens databaser, medan FBI har mer än 400 miljoner datauppsättningar att kalibrera i algoritmer för övervakning av ansiktsigenkänning.

Föreställ dig nu dessa datauppsättningar jämfört med en enda bild som kanske eller inte har fångat alla ansiktsdrag hos den specifika personen. I ett sådant scenario uppstår sannolikt fel. Det finns helt enkelt för mycket data för att förstå och köra det mot ett ansiktsavtryck. Ingen algoritm kan garantera hundraprocentig säkerhet i sitt resultat när kalibreringen är så komplicerad. Detta läggs så småningom upp till den rasprofilering som orsakas av teknik för ansiktsigenkänning.

Den enorma tillförlitligheten för ansiktsigenkänning

Bildkälla: NY Post

Fallet med Willie Lynch är en påminnelse om att ansiktsigenkänning inte bör vara den enda tillförlitliga tekniken som presenteras som bevis när det gäller brottsbekämpning. Detta är anledningen till att polisen i Tampa gav upp tekniken.

Det är sant att ansiktsigenkänning är en utmärkt utväg och är till hjälp för polisen. Boston Marathon Bombings gärningsmän erkändes med hjälp av omfattande och detaljerad analys av övervakningsinspelningar. Men detta kan inte vara det enda beviset för att döma någon. Det måste finnas stödjande bevis för att bevisa resultaten av ansiktsigenkänningsalgoritmerna, och konceptet med automatiseringsbias måste övervägas innan man når en slutgiltig beslutsamhet.

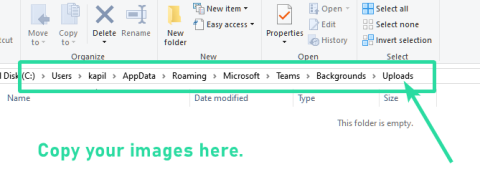

Hårdvaruproblemet: Ansiktsigenkänning i mobiler och kameror

Bildkälla: TechCrunch

Övervakningskamerasystemen och tillhörande hårdvara och mjukvara är inte designade av ett enda företag. Det är en industri värd miljarder dollar där tiotals företag tävlar om att få kontrakt från brottsbekämpande myndigheter. Många av dessa system är från kinesiska tillverkare. Allt handlar om att få den billigaste tekniken med de bästa egenskaperna. Det är så det fungerar för det mesta. Och därför finns det alltid chanser för skillnader i kalibrering av olika system, såväl som variation i kvaliteten på övervakningsresultat. Många kameraövervakningsalgoritmer är ineffektiva när det gäller att kalibrera bilder av färgade personer bara på grund av teknisk inkompetens, vilket glorifierar rasdiskriminering.

De tekniska problemen som orsakar rasism via ansiktsigenkänning har också uppmärksammats i Apple Face Lock-funktionen. Ett fall från Kina tog bort att iPhone X ansiktslås inte kunde skilja mellan två olika kinesiska medarbetare, vilket gjorde funktionen värdelös. Liknande rapporter avfärdades, med hänvisning till problem i inslaget i att skilja två svarta personer från varandra. Som nämnts ovan har Apple bara 6% av svarta personer i tekniska team. Det är ett tydligt exempel på hur en ansiktsigenkänningsteknik kan främja rasism även i våra handhållna enheter.

Slutsats

Ja, ansiktsigenkänning är rasistiskt, och det är allmänt känt nu. Medan tekniken växer dagligen för att åtgärda sådana problem, är resultaten desamma. Tekniken är tänkt att förena världen över gemensamma mål för tekniska framsteg och utveckling, men vissa tekniker skadar bara ras- och kommunal harmoni.

För närvarande är det bästa brottsbekämpande tjänstemän kan göra att inte stödja sina fall baserat på bevis från algoritmiska kalibreringar, som inte ens är tillförlitliga. Dessutom är det hög tid att mångfald och inkludering på arbetsplatser tas på allvar så att människor av alla etniciteter kan gå samman för att skapa en produkt som är fri från rasskillnader. Det finns tusentals raser i världen, och människor har vuxit till att lägga rasskillnaderna åt sidan, som förföljt det globala samhället så länge. Om det måste upprätthållas måste de maskiner som vi förlitar oss så mycket på läras ut på samma sätt.

![Ta reda på hur du gör försättssidor i Google Dokument [Enkla steg] Ta reda på hur du gör försättssidor i Google Dokument [Enkla steg]](https://blog.webtech360.com/resources3/images10/image-336-1008140654862.jpg)