Kuidas Facebookis küsitlust luua?

Kui otsite, kuidas luua Facebookis küsitlust, et saada inimeste arvamust, siis meilt leiate kõik lahendused alates sündmustest, messengerist kuni looni; saate Facebookis küsitluse luua.

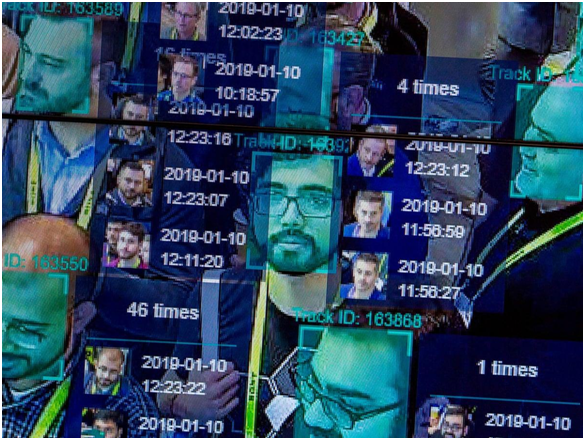

Näotuvastustehnoloogia ja selle võimed on kasvanud meie kujutlusvõimest kaugemale sellest ajast, kui uued algoritmid selle tehnoloogia tugevdamiseks õiguskaitses on esile kerkinud. Praegu kasutavad korrakaitsejõud näotuvastustehnoloogiat andmete kogumise protsesside madalaimal tasemel, et tuvastada kurjategijaid rahvarohkete kogunemiste ajal. Tehnika kasutab avalikes kohtades ja tänavatel CCTV-kaamerate kaadreid ning seejärel kontrollib kogutud andmeid agentuuri arhiivides, et tuvastada kuritegude eest tagaotsitav nägu.

Seda tehnoloogiat on manustatud ka kõige väiksematesse vidinatesse, sealhulgas mobiiltelefonidesse ja nutikatesse kantavatesse seadmetesse. Seega ei kaitse see mitte ainult teid tänavatel, vaid kavatseb kaitsta ka teie nutiseadmetesse salvestatud isiklikku teavet. Näojälje kasutamine turundus- ja reklaamipraktikate jaoks on sotsiaalmeedia kampaaniate kaasaegsel ajastul muutunud tavaliseks. Ja siis toimub privaatne jälgimine kaubanduskeskustes, jaekauplustes jne.

Sellest vaatenurgast saab kiiresti välja tuua näotuvastustehnoloogia vaieldamatud eelised. Kuid seda on kontrollitud ka selle ohu osas, mida see kujutab kasutajate privaatsusele, andmekaitsele ning loomulikult ka seaduse ja avalikkuse vahelisele läbipaistvusele. Hea on olla teadlik sellise invasiivse tehnoloogia eelistest ja puudustest. Kuid näotuvastustehnoloogial on veel üks puudus, mida inimesed näivad ignoreerivad, ja see on rassiline profiilide koostamine ja rassiline diskrimineerimine .

Selles artiklis vaatleme, kuidas see tehnoloogia soodustab rassilist eelarvamust ja diskrimineerimist ning kui tõsised on sellise invasiivse tehnoloogia tagajärjed.

Kuidas näotuvastus toimib?

Pildi allikas: National Post

1. samm . Pilt tehakse teist kaamerast, teie kontolt, e-posti teel jne. See on kas sirge profiilipilt või juhuslik pilt.

2. toiming . Näotuvastustarkvara käitab teie nägu läbi salvestatud näojälgede andmebaasi. Näojälg kogutakse teie näo geomeetrilise jälgimise teel.

3. samm: teie pildi ja mis tahes teadaoleva näojälje vaste protsent luuakse algoritmi abil, mille põhjal tehakse kindlaksmääramine.

Automatiseerimise eelarvamus: üks paljudest näotuvastustehnoloogia puudustest

Automation Bias või Machine Bias viitab stsenaariumile, kus masina algoritmil on sisendandmete kalibreerimisel teatud nihe, andes seega ebasoodsa väljundi. See juhtub siis, kui algoritmi koodis on viga, kalibreerimiseks pole salvestatud andmekogumeid, valesid sisendväärtusi või liiga palju sisendandmeid, mille kalibreerimine ei ole masinatel jõukohane.

Kuidas rassiline profileerimine selle kõigega käib?

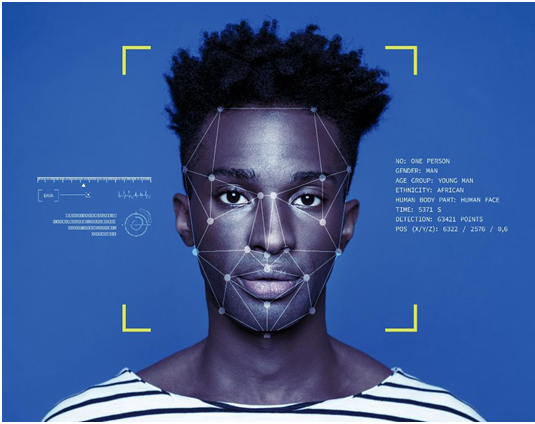

Pildi allikas: The Guardian

Alustame iidsest juhtumist, mida sel ajal peeti tähtsusetuks. 2001. aastal kasutas Tampa City näotuvastustarkvara rahvarohke linna jälgimiseks, kuna turistid ujutasid 2001. aasta Super Bowli tõttu linnatänavaid üle. New York Timesi aruande kohaselt tuvastas tarkvara 19 inimest, kellel oli väidetavalt nende vastu kehtiv order; vahistamisi siiski ei tehtud, kuna staadioni infrastruktuur ei võimaldanud tuvastatud süüdlasteni jõuda tohutu rahvahulga seas.

Kuigi sel konkreetsel juhul ei olnud rassilise profiili koostamise märke kusagil näha, oli see esimene kord, kui jälgimistehnikaid rakendati üksikisikute kodanikuvabaduste ja eraelu puutumatuse rikkumise vastu. Järgnevatel aastatel loobus Tampa politsei nendest jälgimissüsteemidest, viidates ebausaldusväärsetele tulemustele.

Pildi allikas: ICO

Mõnevõrra uuemale stsenaariumile edasi liikudes teatas Ali Breland ajalehele The Guardian Willie Lynchi, mustanahalise mehe vahistamise kohta, keda süüdistatakse kurikuulsas narkodiileris Brentwoodi piirkonnas, mis on valdavalt värviliste inimeste naabruses. Ainus tõend Lynchi vastu oli tema mobiiltelefonis olevad pildid, mida käitati politsei andmebaasi vastu enne, kui politsei ta süüdlaseks määras. Lynch mõisteti kaheksaks aastaks süüdi, kes on nüüd süüdimõistva otsuse edasi kaevanud. Olenemata sellest, kas ta oli väidetav edasimüüja või mitte, tekitab paratamatult muret, kas ainult masinapõhisest tulemusest piisab, et jätta jõusse kõigi uurimise all olevate isikute süüdimõistmine?

Nagu Tom Perkins The Guardianile teatas, leiti 2019. aastal Detroidi politsei, kes kasutas väidetavalt viimase kahe aasta jooksul arreteerimiseks näotuvastust. Detroit on koht, kus üle 80% elanikkonnast on mustanahalised. Detroidi politseikomisjoni mustanahalise liikme avaldus tekitas muret selle praktika pärast. Ta ütles, et mustanahalistel inimestel on ühine näojoon, mis seab ohtu süsteemi algoritmi, nimetades seda tehnorassismiks.

Pildi allikas: Vox

Fabio Bacchini ja Ludovica Lorusso ajakirja Journal of Information Communication and Ethics Society 2019. aasta uuringus leiti, et need biomeetrilised ja näotuvastussüsteemid ei ole õiguskaitseorganite jaoks 100% usaldusväärsed. Lisaks avaldas rassiline diskrimineerimine negatiivset mõju kõikidele sellistele süsteemidele, millel on ka vastupidine ühiskondlik mõju. Uuring oli suunatud eelkõige lääneriikidele, kus selliseid süsteeme kasutatakse laialdaselt jälgimiseks.

Need on vaid kolm paljudest sellistest näidetest, kus näotuvastussüsteemidest põhjustatud rassilised erinevused on päevavalgele tulnud. Kuid miks on need süsteemid nii ebapädevad, hoolimata sellisest kasvavast täpsusest tehnoloogia algoritmilise kodeerimise uuendustes.

Valge ülemvõim lääneriikides: valge domineeriv tehnikatööstus

2014. aastal leiti, et enamik tehnoloogiaettevõtteid, sealhulgas hiiglane Apple Inc., palkas peamiselt valgenahalisi meessoost töötajaid. Apple'is oli 55% töötajatest valgenahalised ja Apple'i juhtkond moodustas 63% valgenahalistest. Sarnaseid mitmekesisuse aruandeid jaganud ettevõtted olid ka Facebook , Google ja Twitter. Viis aastat hiljem avaldas Wiredi aruanne, et need numbrid on paranenud minimaalselt.

Kui Facebook näitas numbrite korralikku paranemist, siis Apple'i mustanahaliste tehniliste töötajate protsent ei muutunud, vaid 6% kogu tööjõust. Amazon oli ainus organisatsioon, mis registreeris oma USA kontorites 42% mustanahalistest või Ladina-Ameerika töötajatest.

Mida see statistika tähendab? USA-s on enamik kodeerijaid, kes on määratud suurprojektide jaoks, näiteks seiresüsteemide algoritmide kujundamiseks, valged. Need on inimesed, kes teevad kõige olulisemad otsused toote või teenuse osas, mille ettevõte turule toob/esitatab. Ja seega on nende vaatenurgad, lähenemine ja mõtlemisprotsessid need, mis lähevad lõplikku loomingusse. See ei tähenda, et valged inimesed on rassistid ja on sellised jälgimissüsteemid sihilikult loonud . EI!

Pildi allikas: Forbes

Kui valge mees kujundab näotuvastusalgoritmi ja teda nõustavad/abistavad ainult valged kolleegid, ei arvesta nad enne koodi lõplikku vormistamist teist värvi näoomadustega inimesi. Kuna tehnikatööstuses domineerivad valged insenerid, loovad ja kalibreerivad ka esialgse koodi ettevalmistamiseks kasutatavad andmearhiivid valged tehnikud. Seega luuakse kood ise oma põhilises arvutusalgoritmis kallutatult, mille tulemuseks on need rassilised erinevused jälgimistulemustes.

Kood lihtsalt õpib, mida valged inimesed selles kehastavad. Ühelgi teist värvi inimesel pole perspektiivi ega panust.

Kalibreerimise probleemid

Ameerika õiguskaitseorganid sõltuvad suuresti jälgimisest ja andmete jälgimisest. On olnud palju juhtumeid, kus vilepuhujad on välja tõrjunud teavet tsiviilisikute volitamata jälgimise kohta. Üks selline näide on Edward Snowdeni paljastus NSA ebaseaduslikust jälgimisest.

Pildi allikas: CBS Local

Neid jälgimisprogramme toetavad miljonite kodanike näojäljed ja muu isiklik teave. Kui arvestada ainult näojälgi, on miljonid ameeriklased, kes jagavad sotsiaalmeedia platvormidel avalikult pilte. Siis on riigi igal tänaval CCTV-kaamerad , mis pakuvad otsepilti sadadest tuhandetest möödujatest. Praegu on politsei andmebaasides ligikaudu 117 miljonit pilti, samal ajal kui FBI-l on enam kui 400 miljonit andmestikku, mida jälgimisnäotuvastusalgoritmides kalibreerida.

Kujutage nüüd ette, et neid andmekogumeid võrreldakse ühe pildiga, mis võib olla või mitte jäädvustada konkreetse inimese kõiki näojooni. Sellise stsenaariumi korral tekivad tõenäoliselt vead. Andmeid on lihtsalt liiga palju, et neid mõista ja ühe näojäljega võrrelda. Ükski algoritm ei saa garanteerida oma tulemuse sajaprotsendilist kindlust, kui kalibreerimine on nii keeruline. Lõpuks lisandub see näotuvastustehnoloogia põhjustatud rassilisele profiilile.

Näotuvastuse tohutu usaldusväärsus

Pildi allikas: NY Post

Willie Lynchi juhtum tuletab meelde, et näotuvastus ei tohiks olla ainus usaldusväärne meetod, mida õiguskaitses tõendina esitatakse. See on põhjus, miks Tampa linnapolitsei tehnikast loobus.

Tõsi, näotuvastus on suurepärane abinõu ja abiks politseile. Bostoni maratoni pommirünnakute süüdlased tuvastati jälgimissalvestiste ulatusliku ja üksikasjaliku analüüsi abil. Kuid see ei saa olla ainus tõend kellegi süüdimõistmiseks. Näotuvastusalgoritmide tulemuste tõendamiseks peavad olema tõendid ja enne lõpliku otsuse tegemist tuleb kaaluda automatiseerimise kallutatuse kontseptsiooni.

Riistvaraprobleemid: näotuvastus mobiiltelefonides ja kaamerates

Pildi allikas: TechCrunch

Valvekaamerasüsteemid ning nendega seotud riist- ja tarkvara ei ole loodud ühe ettevõtte poolt. See on miljardeid dollareid väärt tööstus, kus kümned ettevõtted võistlevad, et saada õiguskaitseasutustelt lepinguid. Paljud neist süsteemidest on Hiina tootjatelt. See kõik seisneb kõige odavama ja parimate omadustega tehnoloogia hankimises. Nii see enamasti käibki. Seetõttu on alati võimalik, et erinevate süsteemide kalibreerimisel on erinevusi ja ka seiretulemuste kvaliteeti. Paljud kaameraseire algoritmid on ebaefektiivsed värviliste inimeste kujutiste kalibreerimisel lihtsalt tehnilise ebakompetentsuse tõttu, ülistades seega rassilist diskrimineerimist.

Näotuvastuse kaudu rassismi põhjustavaid tehnilisi probleeme on märgatud ka Apple'i näoluku funktsioonis. Hiinast pärit juhtum tõi välja, et iPhone X näolukk ei suutnud eristada kahte erinevat Hiina kolleegi, muutes selle funktsiooni kasutuks. Sarnased teated lükati tagasi, viidates kahe mustanahalise inimese üksteisest eraldamise probleemidele. Nagu eespool öeldud, on Apple'i tehnilistes meeskondades vaid 6% mustanahalisi inimesi. See on selge näide sellest, kuidas näotuvastustehnoloogia võib edendada rassismi isegi meie pihuarvutites.

Järeldus

Jah, näotuvastus on rassistlik ja see on praegu üldteada. Kuigi tehnoloogia areneb iga päev selliste probleemide lahendamiseks, on tulemused kõik ühesugused. Tehnoloogia peaks ühendama maailma tehniliste edusammude ja arengu ühiste eesmärkide nimel, kuid mõned tehnikad kahjustavad lihtsalt rassilist ja kogukondlikku harmooniat.

Praegu on parim, mida õiguskaitseametnikud teha saavad, mitte toetada oma juhtumeid, tuginedes algoritmilise kalibreerimise tõenditele, mis pole isegi usaldusväärsed. Lisaks on viimane aeg võtta mitmekesisust ja kaasatust töökohtadel tõsiselt, et kõigist rahvustest inimesed saaksid kokku tulla, et luua toode, mis on vaba rassilistest erinevustest. Maailmas on tuhandeid rasse ja inimesed on hakanud kõrvale jätma rassilised erinevused, mis on globaalset ühiskonda nii kaua kummitanud. Kui seda tuleb säilitada, tuleb sama õpetada ka masinatele, millele me nii palju tugineme.

Kui otsite, kuidas luua Facebookis küsitlust, et saada inimeste arvamust, siis meilt leiate kõik lahendused alates sündmustest, messengerist kuni looni; saate Facebookis küsitluse luua.

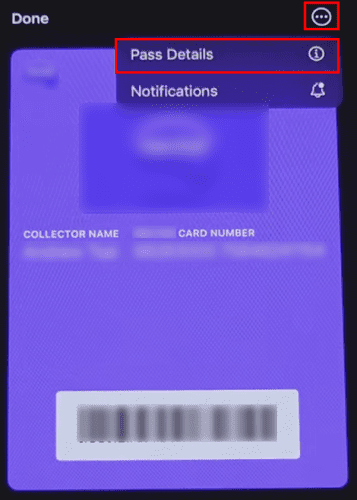

Kas soovite aegunud pääsmeid kustutada ja Apple Walleti korda teha? Järgige selles artiklis, kuidas Apple Walletist üksusi eemaldada.

Olenemata sellest, kas olete täiskasvanud või noor, võite proovida neid värvimisrakendusi, et vallandada oma loovus ja rahustada meelt.

See õpetus näitab, kuidas lahendada probleem, kuna Apple iPhone'i või iPadi seade kuvab vales asukohas.

Vaadake, kuidas saate režiimi Mitte segada iPadis lubada ja hallata, et saaksite keskenduda sellele, mida tuleb teha. Siin on juhised, mida järgida.

Vaadake erinevaid viise, kuidas saate oma iPadi klaviatuuri suuremaks muuta ilma kolmanda osapoole rakenduseta. Vaadake ka, kuidas klaviatuur rakendusega muutub.

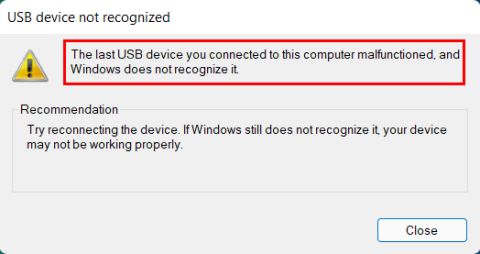

Kas seisate silmitsi sellega, et iTunes ei tuvasta oma Windows 11 arvutis iPhone'i või iPadi viga? Proovige neid tõestatud meetodeid probleemi koheseks lahendamiseks!

Kas tunnete, et teie iPad ei anna tööd kiiresti? Kas te ei saa uusimale iPadOS-ile üle minna? Siit leiate märgid, mis näitavad, et peate iPadi uuendama!

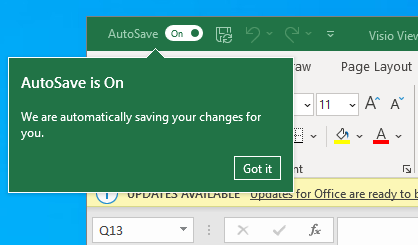

Kas otsite juhiseid, kuidas Excelis automaatset salvestamist sisse lülitada? Lugege seda juhendit automaatse salvestamise sisselülitamise kohta Excelis Macis, Windows 11-s ja iPadis.

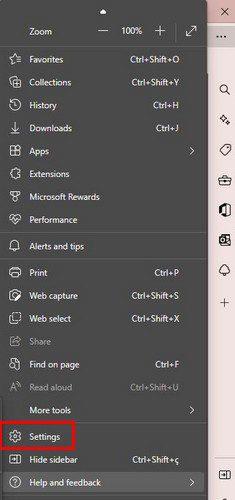

Vaadake, kuidas saate Microsoft Edge'i paroole kontrolli all hoida ja takistada brauserit tulevasi paroole salvestamast.