Ansigtsgenkendelsesteknologi og dens evner er vokset langt ud over vores fantasi, lige siden nye algoritmer til at forstærke denne teknologi inden for retshåndhævelse er blevet fremtrædende. I øjeblikket bruges ansigtsgenkendelsesteknologi af retshåndhævende styrker på de laveste niveauer af dataindsamlingsprocesser til at identificere kriminelle lovovertrædere midt i overfyldte forsamlinger. Teknikken bruger optagelser fra CCTV-kameraer på offentlige steder og gader og kører derefter de indsamlede data mod agenturets arkiver for at opdage et ansigt, der er eftersøgt for kriminelle handlinger.

Denne teknologi er yderligere blevet integreret i de mindste gadgets, inklusive mobiltelefoner og smarte bærbare enheder. Derfor beskytter den ikke kun dig på gaden, men har også til hensigt at beskytte dine personlige oplysninger, der er gemt på dine smartenheder. Brug af "ansigtsaftryk" til markedsføring og annoncering er blevet almindeligt i den moderne tidsalder med kampagner på sociale medier. Og så er der privat overvågning i indkøbscentre, detailbutikker osv.

Fra dette perspektiv kan man hurtigt påpege de ubestridelige fordele ved ansigtsgenkendelsesteknologi. Men det er også blevet undersøgt for den trussel, det udgør mod brugernes privatliv, databeskyttelse og selvfølgelig gennemsigtigheden mellem loven og offentligheden. Det er en god ting at være opmærksom på både fordele og ulemper ved sådan en invasiv teknologi. Alligevel er der endnu en ulempe ved ansigtsgenkendelsesteknologien, som folk ser ud til at ignorere, og det er raceprofilering og racediskrimination .

I dette stykke ser vi på, hvordan denne teknologi fremmer racemæssig skævhed og diskrimination, og hvor alvorlige følgerne af en sådan invasiv teknologi er.

Hvordan virker ansigtsgenkendelse?

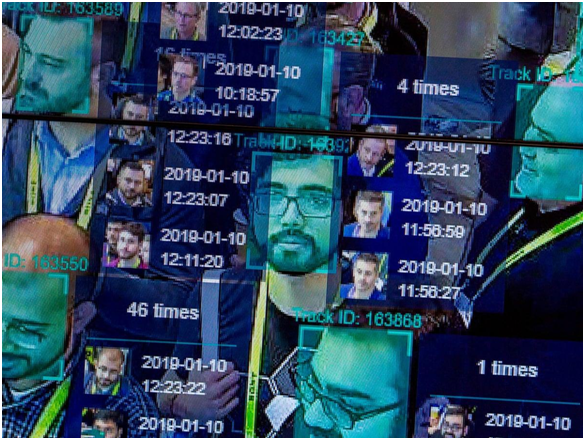

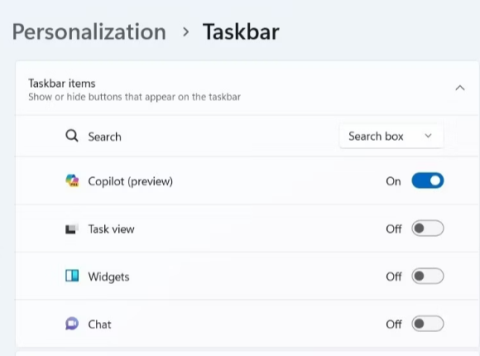

Billedkilde: National Post

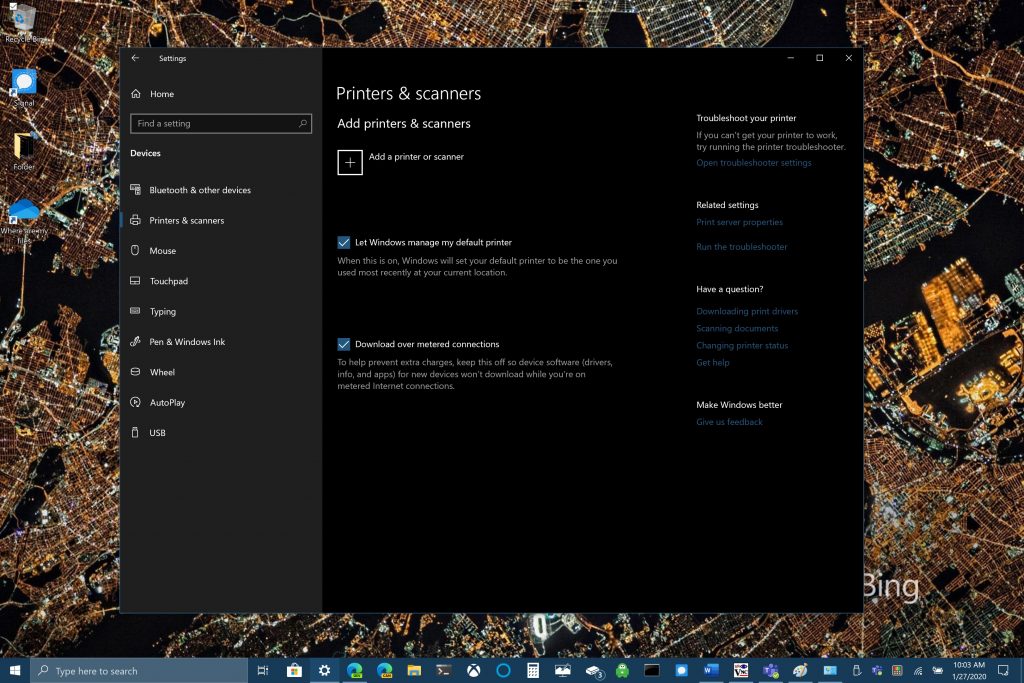

Trin 1: Et billede af dig er taget fra et kamera, din konto, e-mail osv. Det er enten et lige profilbillede eller et tilfældigt snap i en menneskemængde.

Trin 2: Ansigtsgenkendelsessoftwaren vil køre dit ansigt gennem en database med gemte ansigtsaftryk. Ansigtsaftrykket samles via geometrisk sporing af dit ansigt.

Trin 3: En matchprocent af dit billede i forhold til et kendt ansigtsaftryk er fremstillet ved hjælp af en algoritme, over hvilken der foretages en bestemmelse.

Automation Bias: En af mange fejl ved ansigtsgenkendelsesteknologi

Automation Bias eller Machine Bias refererer til scenariet, hvor en maskinalgoritme udviser en vis bias i kalibreringen af inputdataene, hvilket giver ugunstigt output. Dette sker, når der er en fejl i algoritmekoden, mangel på lagrede datasæt til kalibrering, forkerte inputværdier eller overdreven inputdata, hvilket er ud over maskinens styrke til at kalibrere.

Hvordan raceprofilering går med alt dette?

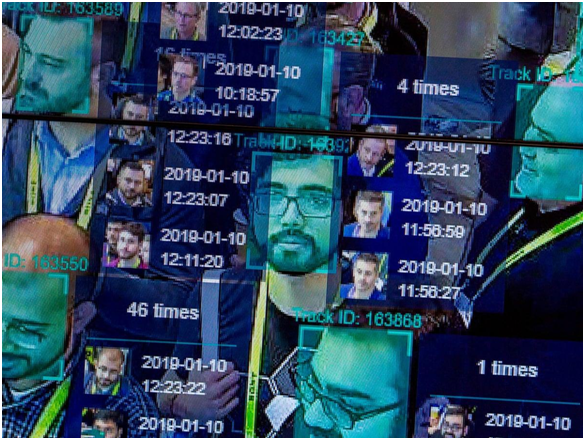

Billedkilde: The Guardian

Lad os starte med en gammel hændelse, som på det tidspunkt blev anset for ubetydelig. I 2001 brugte Tampa City ansigtsgenkendelsessoftware til overvågning af den overfyldte by, da turister oversvømmede byens gader på grund af Super Bowl i 2001. Ifølge en rapport fra New York Times identificerede softwaren 19 personer, som angiveligt havde udestående kendelser mod dem; dog blev der ikke foretaget nogen anholdelser, da infrastrukturen på stadion gjorde det umuligt at komme til de identificerede skyldige blandt en overvældende folkemængde.

Mens tegnene på raceprofilering ikke blev set nogen steder i dette særlige tilfælde, var det første gang, der blev sat overvågningsteknikker op mod krænkelse af borgerlige frihedsrettigheder og enkeltpersoners privatliv. I de kommende år opgav Tampa-politiet disse overvågningssystemer med henvisning til upålidelige resultater.

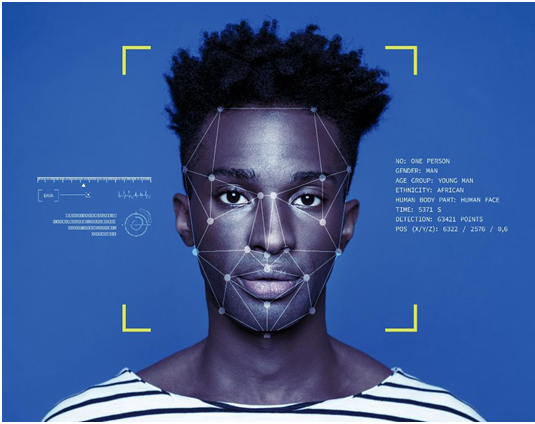

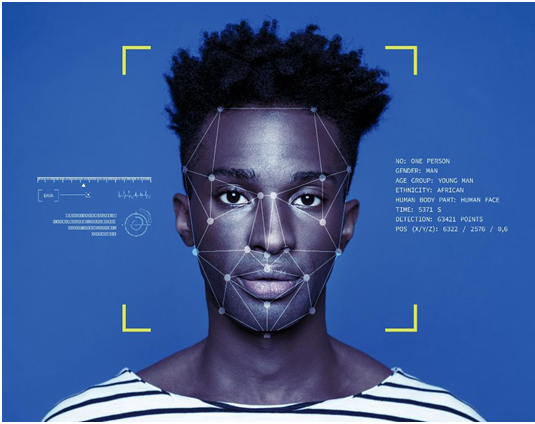

Billedkilde: ICO

Hurtigt frem til et noget nyere scenarie rapporterede Ali Breland for The Guardian om en anholdelse af Willie Lynch, en sort mand anklaget for at være en berygtet narkohandler i Brentwood-området, overvejende et kvarter af farvede mennesker. Det eneste bevis mod Lynch var hans billeder på en mobil, som blev kørt mod en politidatabase, før politiet fastslog ham som den skyldige. Lynch blev dømt i otte år, som nu har anket dommen. Uanset om han var den påståede forhandler eller ej, vækker det uundgåeligt bekymring over, om kun et maskinbaseret resultat er nok til at opretholde domfældelsen for nogen, der er under undersøgelse?

I 2019, som rapporteret af Tom Perkins for The Guardian , blev Detroit-politiet fundet ved at bruge ansigtsgenkendelse til at foretage anholdelser angiveligt i de sidste to år. Detroit er et sted, hvor mere end 80% af befolkningen er sorte. En erklæring fra et sort medlem fra Detroit Police Commission gav anledning til bekymring over denne praksis. Han sagde, at sorte mennesker har et fælles ansigtstræk, der bringer systemets algoritme i fare, og betegner dette som "techno-racisme."

Billedkilde: Vox

I en undersøgelse fra 2019 for Journal of Information Communication and Ethics Society af Fabio Bacchini og Ludovica Lorusso blev det konstateret, at disse biometriske og ansigtsgenkendelsessystemer ikke er 100 % pålidelige for retshåndhævelse. Desuden var racediskrimination en negativ indvirkning på alle sådanne systemer, hvilket har yderligere omvendte samfundsmæssige konsekvenser. Undersøgelsen var især rettet mod vestlige samfund, hvor sådanne systemer i vid udstrækning bruges til overvågning.

Dette er blot tre af mange sådanne eksempler, hvor tilfælde af raceforskelle forårsaget af ansigtsgenkendelsessystemer er kommet frem i lyset. Men hvorfor er disse systemer så inkompetente på trods af en sådan voksende nøjagtighed i algoritmiske kodningsopgraderinger i teknologi.

White Supremacy in the Western States: A White-Dominant Tech Industry

I 2014 blev det konstateret, at et flertal af tech-virksomheder, inklusive giganten Apple Inc., ansætter hovedsageligt hvide, mandlige medarbejdere. I Apple var 55 % af medarbejderne hvide, og på samme måde omfattede Apples ledelse 63 % af hvide medarbejdere. De virksomheder, der delte lignende mangfoldighedsrapporter, inkluderede også Facebook , Google og Twitter. Fem år senere afslørede en rapport i Wired, at der havde været minimal forbedring i disse tal.

Mens Facebook viste en anstændig fremgang i antallet, var Apples procentdel af sorte tekniske arbejdere uændret på kun 6 % af den samlede arbejdsstyrke. Amazon var den eneste organisation, der registrerede 42 % sorte eller latinamerikanske arbejdere på sine amerikanske kontorer.

Hvad betyder disse statistikker? I USA er de fleste kodere, som er tildelt store projekter som at designe algoritmer til overvågningssystemer, hvide. Det er de mennesker, der træffer de vigtigste beslutninger vedrørende et produkt eller en tjeneste, der skal lanceres/afsløres af en virksomhed. Og derfor er det deres perspektiver, tilgang og tankeprocesser, der går i den endelige skabelse. Dette betyder ikke, at hvide mennesker er racister og med vilje har designet sådanne overvågningssystemer . INGEN!

Billedkilde: Forbes

Når en hvid fyr designer en ansigtsgenkendelsesalgoritme og kun har hvide kollegaer til at rådgive/bistå ham, tager de ikke hensyn til personer af anden farves ansigtstræk, før de færdiggør koden. Da hvide ingeniører dominerer tech-industrien, er dataarkiverne, der bruges til at forberede den indledende kode, også oprettet og kalibreret af hvide teknikere. Således er selve koden skabt med en bias i dens kerneberegningsalgoritme, hvilket resulterer i disse racemæssige forskelle i overvågningsresultater.

Koden lærer simpelthen, hvad hvide mennesker inkarnerer i den. Der er intet perspektiv eller bidrag fra nogen person af en anden farve.

Kalibreringsproblemerne

Amerikansk retshåndhævelse er stærkt afhængig af overvågning og datasporing. Der har været mange tilfælde, hvor whistleblowere fordrev information om uautoriseret overvågning af civile. Edward Snowdens afsløring af NSAs ulovlige overvågning er et sådant eksempel.

Billedkilde: CBS Local

Disse overvågningsprogrammer understøttes af ansigtsaftryk og andre personlige oplysninger fra millioner af borgere. Hvis vi kun overvejer ansigtsaftryk, er der millioner af amerikanere, der åbenlyst deler billeder på sociale medieplatforme. Så er der CCTV-kameraer i alle gader i landet, der tilbyder live-optagelser af hundredtusindvis af forbipasserende. I øjeblikket er der cirka 117 millioner billeder i politiets databaser, mens FBI har mere end 400 millioner datasæt til at kalibrere i overvågnings-ansigtsgenkendelsesalgoritmer.

Forestil dig nu disse datasæt sammenlignet med et enkelt billede, der måske eller måske ikke har fanget alle ansigtstræk hos den pågældende person. I et sådant scenarie vil der sandsynligvis opstå fejl. Der er bare for mange data til at forstå og køre dem mod ét ansigtsaftryk. Ingen algoritme kan garantere hundrede procent sikkerhed for sit resultat, når kalibrering er så kompliceret. Dette tilføjer til sidst den racemæssige profilering forårsaget af ansigtsgenkendelsesteknologi.

Den enorme pålidelighed på ansigtsgenkendelse

Billedkilde: NY Post

Sagen om Willie Lynch er en påmindelse om, at ansigtsgenkendelse ikke bør være den eneste pålidelige teknik, der præsenteres som bevis, når det kommer til retshåndhævelse. Dette er grunden til, at politiet i Tampa opgav teknologien.

Det er rigtigt, at ansigtsgenkendelse er en fremragende udvej og er nyttig for politiet. Boston Marathon Bombnings skyldige blev anerkendt ved hjælp af omfattende og detaljeret analyse af overvågningsoptagelser. Men dette kan ikke være det enestående bevis for at dømme nogen. Der skal være underbyggende beviser for at bevise resultaterne af ansigtsgenkendelsesalgoritmerne, og begrebet automatiseringsbias skal overvejes, før man når en endelig beslutning.

Hardwareproblemet: Ansigtsgenkendelse i mobiler og kameraer

Billedkilde: TechCrunch

Overvågningskamerasystemerne og tilhørende hardware og software er ikke designet af én enkelt virksomhed. Det er en industri, der er milliarder af dollars værd, hvor snesevis af virksomheder konkurrerer om at få kontrakter fra retshåndhævende myndigheder. Mange af disse systemer er fra kinesiske producenter. Det handler om at få den billigste teknologi med de bedste kvaliteter. Sådan fungerer det for det meste. Og derfor er der altid chancer for forskelle i kalibrering af forskellige systemer, samt variation i kvaliteten af overvågningsresultater. Mange kameraovervågningsalgoritmer er ineffektive til at kalibrere billeder af farvede mennesker blot på grund af teknisk inkompetence, og forherliger dermed racediskrimination.

De tekniske problemer, der forårsager racisme via ansigtsgenkendelse, er også blevet bemærket i Apple Face Lock-funktionen. En sag fra Kina fjernede, at iPhone X-ansigtslåsen ikke var i stand til at skelne mellem to forskellige kinesiske kolleger, hvilket gjorde funktionen ubrugelig. Lignende rapporter blev afvist, idet de citerede problemer i indslaget med at adskille to sorte mennesker fra hinanden. Som nævnt ovenfor har Apple kun 6% af sorte mennesker i tekniske teams. Det er et tydeligt eksempel på, hvordan en ansigtsgenkendelsesteknologi kan fremme racisme selv i vores håndholdte enheder.

Konklusion

Ja, ansigtsgenkendelse er racistisk, og det er almindelig kendt nu. Mens teknologien vokser dagligt for at rette op på sådanne problemer, er resultaterne alle de samme. Teknologi formodes at forene verden over fælles mål for tekniske fremskridt og udvikling, men nogle teknikker forårsager bare skade på racemæssig og kommunal harmoni.

For nu er det bedste, retshåndhævende embedsmænd kan gøre, ikke at støtte deres sager baseret på beviser fra algoritmiske kalibreringer, som ikke engang er pålidelige. Desuden er det på høje tid, at mangfoldighed og inklusion på arbejdspladser tages alvorligt, så mennesker af alle etniciteter kan gå sammen om at skabe et produkt, der er fri for raceforskelle. Der er tusindvis af racer i verden, og folk er vokset til at lægge de racemæssige forskelle til side, som hjemsøgte det globale samfund så længe. Hvis det skal opretholdes, så skal de maskiner, som vi stoler så meget på, læres det samme.