Koneiden nousu: tekoälyn todelliset sovellukset

Tekoäly ei ole tulevaisuudessa, se tässä nykyisyydessä Tässä blogissa Lue kuinka tekoälysovellukset ovat vaikuttaneet eri sektoreihin.

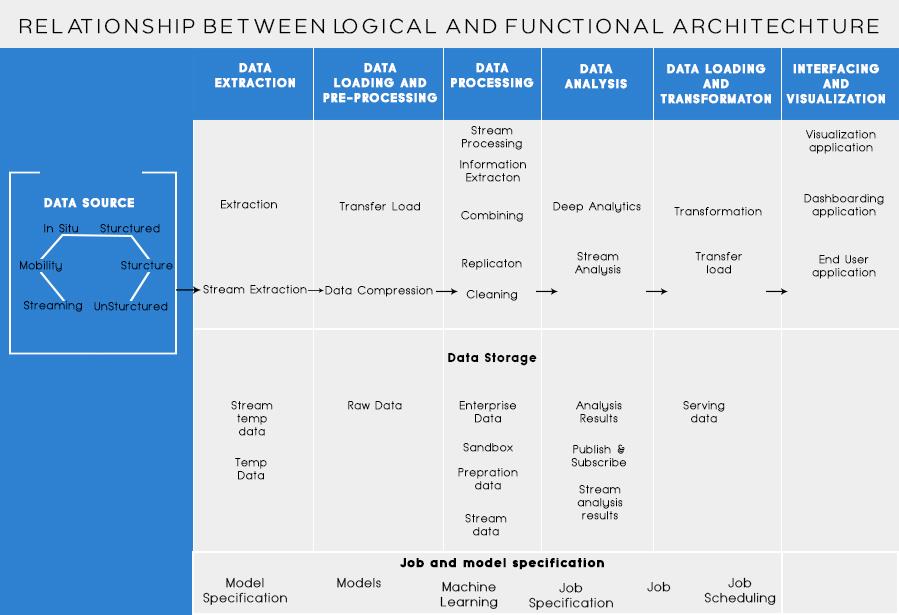

Edellisessä viestissäni keskustelimme liiketoimintaongelman analysoinnista ja Big Data -arkkitehtuurin suunnittelun perusvaiheista. Tänään aion puhua Big Data -arkkitehtuurin eri kerroksista ja niiden toiminnoista.

Big Datan referenssiarkkitehtuurin loogiset kerrokset

Big data -arkkitehtuurin takana ydinajatuksena on dokumentoida arkkitehtuurin, infrastruktuurin ja sovellusten oikea perusta. Näin yritykset voivat käyttää big dataa tehokkaammin joka päivä.

Big datan suunnittelijat/arkkitehdit luovat sen ennen ratkaisun fyysistä toteuttamista. Big data -arkkitehtuurin luominen vaatii yleensä yrityksen/organisaation ja sen big datan tarpeiden ymmärtämistä. Tyypillisesti big data -arkkitehtuurit määrittelevät laitteisto- ja ohjelmistokomponentit, joita tarvitaan big data -ratkaisun toteuttamiseen. Big data -arkkitehtuuridokumentit voivat myös kuvata protokollia tiedon jakamiseen, sovellusintegraatioihin ja tietoturvaan.

Lisätietoja: Big Data Analyticsin aloittelijan opas

Se edellyttää myös olemassa olevien resurssien yhdistämistä ja järjestämistä palvelemaan big datan tarpeita.

Viitearkkitehtuurin loogiset kerrokset ovat seuraavat:

Lähdeprofilointi on yksi tärkeimmistä vaiheista päätettäessä arkkitehtuurista tai big datasta. Se sisältää erilaisten lähdejärjestelmien tunnistamisen ja luokittelun niiden luonteen ja tyypin perusteella.

Tietolähteitä profiloitaessa huomioitavia seikkoja:

Tietojen keräämisessä on kyse tietojen poimimisesta yllä mainituista lähteistä. Nämä tiedot tallennetaan muistiin ja muunnetaan sen jälkeen jatkokäsittelyä varten.

Huomioon otettavat seikat:

Pitäisi pystyä tallentamaan suuria määriä kaikenlaista dataa ja skaalaamaan tarpeen mukaan. Meidän tulisi myös harkita sen tarjoamien IOPS-toimintojen (Input output operations per second) määrää. Hadoop-hajautettu tiedostojärjestelmä on yleisimmin käytetty tallennuskehys Big Data -maailmassa, muut ovat NoSQL-tietovarastot - MongoDB, HBase, Cassandra jne.

Ota huomioon varastointimenetelmiä suunnitellessa:

Tallennetun datan määrän lisäksi myös käsittely on moninkertaistunut.

Aikaisemmin usein käytetty data tallennettiin dynaamisiin RAM-muistiin. Mutta nyt sitä tallennetaan useille levyille useilla koneilla, jotka on kytketty verkon kautta pelkän volyymin vuoksi. Siksi käsittelymoduulit siirretään suurdataan sen sijaan, että kerättäisiin datapaloja käsittelyä varten. Tämä vähentää merkittävästi verkon I/O:ta. Käsittelymenetelmää ohjaavat liiketoiminnan vaatimukset. Se voidaan luokitella eräksi, reaaliaikaiseksi tai hybridiksi SLA:n perusteella.

Tämä kerros kuluttaa käsittelykerroksen tuottamaa tulosta. Eri käyttäjät, kuten järjestelmänvalvojat, yrityskäyttäjät, toimittajat, kumppanit jne., voivat käyttää tietoja eri muodossa. Analyysin tulos voidaan kuluttaa suositusmoottoriin tai liiketoimintaprosessit voidaan käynnistää analyysin perusteella.

Erilaisia tiedonkulutuksen muotoja ovat:

Lue myös: Big Data: tulevaisuuden painajainen?

Big Data -arkkitehtuurin toiminnalliset kerrokset:

Arkkitehtuuria voisi määritellä vielä yksi tapa eli toiminnallisuusjaon kautta. Mutta toiminnallisuusluokat voitaisiin ryhmitellä viitearkkitehtuurin loogiseen kerrokseen, joten ensisijainen arkkitehtuuri tehdään käyttämällä loogisia kerroksia.

Toiminnallisuuksiin perustuva kerros on seuraava:

Tähän luokkaan tulee luetella kaikki lähteet, joista organisaatio saa tiedot ja jotka voivat auttaa organisaatiota tulevien päätösten tekemisessä. Tässä luetellut tietolähteet ovat riippumatta siitä, onko data jäsenneltyä, jäsentämätöntä vai puolirakenteista.

Ennen kuin voit tallentaa, analysoida tai visualisoida tietojasi, sinulla on oltava joitain. Tietojen poiminnassa on kyse jonkin jäsentämättömän sisällön, kuten verkkosivun, ottamisesta ja sen muuttamisesta jäsennellyksi taulukoksi. Kun olet jäsennellyt sen, voit muokata sitä monella eri tavalla käyttämällä alla kuvattuja työkaluja saadaksesi oivalluksia.

Suurin datan parissa työskennellessä perusedellytys on miettiä, kuinka data tallennetaan. Osa siitä, miten Big Data sai eron "BIG", on se, että siitä tuli liikaa perinteisille järjestelmille. Hyvän tiedontallennuspalvelun tarjoajan tulisi tarjota sinulle infrastruktuuri, jossa voit käyttää kaikkia muita analytiikkatyökalujasi, sekä paikka tietojen tallentamiseen ja kyselyihin.

Tämä on välttämätön vaihe ennen kuin alamme louhia tietoja oivalluksia varten. On aina hyvä käytäntö luoda puhdas, hyvin jäsennelty tietojoukko. Tietojoukot voivat olla kaikenmuotoisia ja -kokoisia, varsinkin kun ne tulevat verkosta. Valitse työkalu tietovaatimustesi mukaan.

Tiedonlouhinta on prosessi, jossa haetaan oivalluksia tietokannasta. Tiedonlouhinnan tavoitteena on tehdä päätöksiä ja ennusteita käsilläsi olevan datan perusteella. Valitse ohjelmisto, joka antaa sinulle parhaat ennusteet kaikentyyppisille tiedoille ja antaa sinun luoda omia algoritmeja tiedon louhintaan.

Vaikka tiedon louhinnassa on kyse tietojesi seulomisesta aiemmin tunnistamattomien kuvioiden etsimiseksi, data-analyysissä on kyse tietojen hajottamisesta ja näiden mallien vaikutusten arvioinnista ylitöiden aikana. Analyticsissa on kyse tiettyjen kysymysten esittämisestä ja vastausten löytämisestä tiedoista. Voit jopa kysyä, mitä tulevaisuudessa tapahtuu!

Visualisoinnit ovat kirkas ja helppo tapa välittää monimutkaisia tietoja. Ja mikä parasta, useimmat niistä eivät vaadi koodausta. Datan visualisointiyritykset saavat tietosi eloon. Osa jokaisen datatieteilijän haasteesta on välittää tiedoista saadut oivallukset muulle yrityksellesi. Työkalujen avulla voit luoda kaavioita, karttoja ja muuta vastaavaa grafiikkaa tietosi perusteella.

Tietojen integrointialustat ovat liimaa jokaisen ohjelman välillä. Ne yhdistävät työkalujen erilaiset päätelmät muihin ohjelmistoihin. Voit jakaa visualisointityökalujesi tulokset suoraan Facebookissa näiden työkalujen kautta.

Tietourallasi tulee aikoja, jolloin työkalu ei yksinkertaisesti leikkaa sitä. Vaikka nykyiset työkalut ovat yhä tehokkaampia ja helpompia käyttää, joskus on parempi koodata se itse. On olemassa erilaisia kieliä, jotka auttavat sinua erilaisissa asioissa, kuten tilastolaskennassa ja grafiikassa. Nämä kielet voisivat toimia täydennyksenä tiedon louhinta- ja tilastoohjelmistoille.

Tärkeimmät muistettavat asiat Big Data Architecturea suunnitellessa ovat:

Tiedän, että harkitset erilaisia työkaluja täydellisen Big Data -ratkaisun tekemiseen. No, tulevissa Big Dataa koskevissa viesteissäni käsittelen joitain parhaita työkaluja erilaisten tehtävien suorittamiseen big data -arkkitehtuurissa .

Tekoäly ei ole tulevaisuudessa, se tässä nykyisyydessä Tässä blogissa Lue kuinka tekoälysovellukset ovat vaikuttaneet eri sektoreihin.

Oletko myös DDOS-hyökkäysten uhri ja hämmentynyt ehkäisymenetelmistä? Lue tämä artikkeli ratkaistaksesi kysymyksesi.

Olet ehkä kuullut, että hakkerit ansaitsevat paljon rahaa, mutta oletko koskaan miettinyt, kuinka he ansaitsevat tuollaista rahaa? keskustellaan.

Haluatko nähdä Googlen vallankumouksellisia keksintöjä ja kuinka nämä keksinnöt muuttivat jokaisen ihmisen elämää nykyään? Lue sitten blogia nähdäksesi Googlen keksinnöt.

Konsepti itseohjautuvista autoista lähteä tielle tekoälyn avulla on ollut haaveena jo jonkin aikaa. Mutta useista lupauksista huolimatta niitä ei näy missään. Lue tämä blogi saadaksesi lisätietoja…

Kun tiede kehittyy nopeasti ja ottaa haltuunsa suuren osan ponnisteluistamme, myös riskit altistaa itsemme selittämättömälle singulariteetille kasvavat. Lue, mitä singulaarisuus voisi tarkoittaa meille.

Tietojen säilytystavat ovat kehittyneet mahdollisesti Datan syntymästä lähtien. Tämä blogi käsittelee tiedon tallennuksen kehitystä infografian pohjalta.

Blogista saat tietää Big Data -arkkitehtuurin eri kerroksista ja niiden toiminnoista yksinkertaisimmalla tavalla.

Tässä digitaalisessa maailmassa kodin älylaitteista on tullut tärkeä osa elämää. Tässä on muutamia älykkäiden kodin laitteiden hämmästyttäviä etuja, joiden avulla ne tekevät elämästämme elämisen arvoista ja yksinkertaisempaa.

Apple julkaisi äskettäin macOS Catalina 10.15.4 -lisäpäivityksen ongelmien korjaamiseksi, mutta näyttää siltä, että päivitys aiheuttaa lisää ongelmia, jotka johtavat mac-koneiden tiilikaamiseen. Lue tämä artikkeli saadaksesi lisätietoja