The Rise of Machines: Real World Applications of AI

Kunstig intelligens er ikke i fremtiden, det er her lige i nuet I denne blog Læs, hvordan kunstig intelligens-applikationer har påvirket forskellige sektorer.

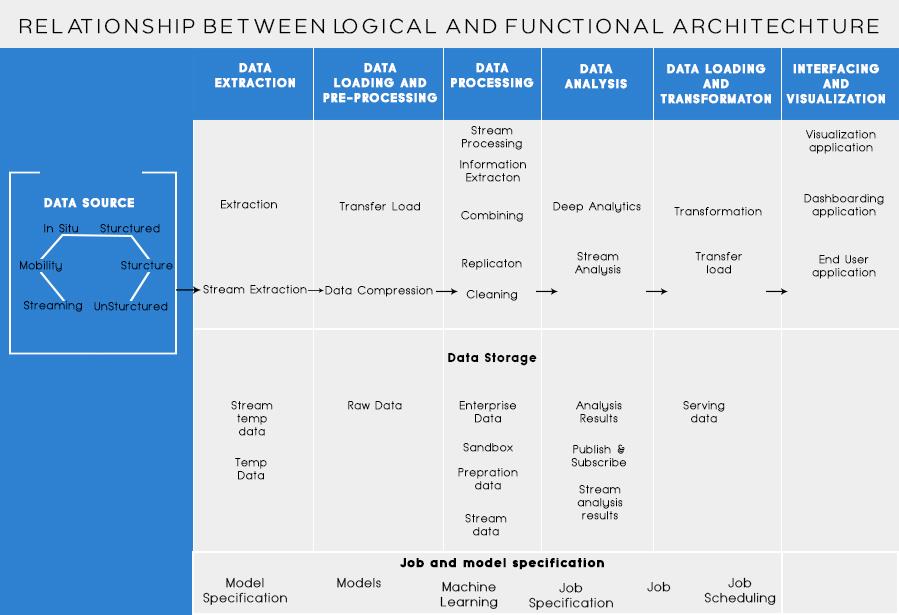

I mit sidste indlæg diskuterede vi analyse af forretningsproblemet og grundlæggende trin til at designe Big Data-arkitekturen. I dag vil jeg tale om forskellige lag i Big Data-arkitekturen og deres funktionaliteter.

Logiske lag af big data-referencearkitektur

Bag big data-arkitektur er kerneideen at dokumentere et rigtigt fundament af arkitektur, infrastruktur og applikationer. Dette giver derfor virksomheder mulighed for at bruge big data mere effektivt i hverdagen.

Det er skabt af big data designere/arkitekter, før de fysisk implementerer en løsning. At skabe big data-arkitektur kræver generelt forståelse for virksomheden/organisationen og dens big data-behov. Typisk skitserer big data-arkitekturer de hardware- og softwarekomponenter, der er nødvendige for at opfylde big data-løsningen. Big data-arkitekturdokumenter kan også beskrive protokoller til datadeling, applikationsintegrationer og informationssikkerhed.

Flere oplysninger: En begyndervejledning til Big Data Analytics

Det indebærer også sammenkobling og organisering af eksisterende ressourcer for at betjene big data-behov.

De logiske lag i referencearkitekturen er som nedenfor:

Kildeprofilering er et af de vigtigste trin i beslutningen om arkitekturen eller big data. Det indebærer at identificere forskellige kildesystemer og kategorisere dem, baseret på deres art og type.

Punkter, der skal tages i betragtning ved profilering af datakilder:

Dataindtagelse handler om udtrækning af data fra ovennævnte kilder. Disse data gemmes i lageret og transformeres derefter til videre behandling på det.

Punkter, der skal overvejes:

Man bør være i stand til at gemme store mængder data af enhver type og bør være i stand til at skalere efter behov. Vi bør også overveje antallet af IOPS (Input output operationer per sekund), som den kan levere. Hadoop distribuerede filsystem er den mest almindeligt anvendte lagringsramme i Big Data-verdenen, andre er NoSQL-datalagrene - MongoDB, HBase, Cassandra osv.

Ting at overveje, når du planlægger opbevaringsmetodologi:

Ikke kun mængden af data, der lagres, men behandlingen er også blevet mangedoblet.

Tidligere hyppigt tilgåede data blev gemt i dynamiske RAM'er. Men nu bliver det gemt på flere diske på en række maskiner, der er forbundet via netværk på grund af ren volumen. Derfor, i stedet for at indsamle data chunks til behandling, tages behandlingsmoduler til big data. Dermed reduceres netværkets I/O markant. Behandlingsmetoden er drevet af forretningskrav. Det kan kategoriseres i batch, realtid eller hybrid baseret på SLA.

Dette lag forbruger output fra behandlingslaget. Forskellige brugere som administrator, forretningsbrugere, leverandør, partnere osv. kan forbruge data i forskellige formater. Output af analyse kan forbruges af anbefalingsmotor eller forretningsprocesser kan udløses baseret på analysen.

Forskellige former for dataforbrug er:

Læs også: Big Data: A Future Nightmare?

Funktionelle lag af Big Data-arkitekturen:

Der kunne være endnu en måde at definere arkitekturen på, dvs. gennem funktionalitetsinddelingen. Men funktionalitetskategorierne kunne grupperes sammen i det logiske lag af referencearkitektur, så den foretrukne arkitektur er en, der udføres ved hjælp af logiske lag.

Lagdelingen baseret på funktionerne er som nedenfor:

Analyser af alle de kilder, hvorfra en organisation modtager data, og som kan hjælpe organisationen med at træffe sine fremtidige beslutninger, bør opføres i denne kategori. Datakilderne anført her er uanset om dataene er strukturerede, ustrukturerede eller semistrukturerede.

Før du kan gemme, analysere eller visualisere dine data, skal du have nogle. Dataudtræk handler om at tage noget, der er ustruktureret, som en webside, og omdanne det til en struktureret tabel. Når du har fået det struktureret, kan du manipulere det på alle mulige måder ved at bruge værktøjerne beskrevet nedenfor for at finde indsigt.

Den grundlæggende nødvendighed, når du arbejder med big data, er at tænke på, hvordan man gemmer disse data. En del af, hvordan Big Data fik udmærkelsen som "BIG", er, at det blev for meget for de traditionelle systemer at håndtere. En god datalagringsudbyder bør tilbyde dig en infrastruktur, hvorpå du kan køre alle dine andre analyseværktøjer samt et sted at gemme og forespørge om dine data.

Et forud nødvendigt skridt, før vi rent faktisk begynder at mine dataene for at få indsigt. Det er altid en god praksis at skabe et rent, velstruktureret datasæt. Datasæt kan komme i alle former og størrelser, især når de kommer fra nettet. Vælg et værktøj i henhold til dit datakrav.

Data mining er processen med at opdage indsigt i en database. Formålet med data mining er at træffe beslutninger og forudsigelser på de data, du har ved hånden. Vælg en software, der giver dig de bedste forudsigelser for alle typer data og lader dig oprette dine egne algoritmer til at mine dataene.

Mens data mining handler om at gennemse dine data på jagt efter hidtil ukendte mønstre, handler dataanalyse om at nedbryde disse data og vurdere virkningen af disse mønstre overarbejde. Analytics handler om at stille specifikke spørgsmål og finde svarene i data. Du kan endda stille spørgsmål om, hvad der vil ske i fremtiden!

Visualiseringer er en lys og nem måde at formidle kompleks dataindsigt på. Og det bedste er, at de fleste af dem ikke kræver nogen kodning. Datavisualiseringsvirksomheder vil få dine data til at komme til live. En del af udfordringen for enhver dataforsker er at formidle indsigten fra disse data til resten af din virksomhed. Værktøjer kan hjælpe dig med at skabe diagrammer, kort og anden sådan grafik ud fra din dataindsigt.

Dataintegrationsplatforme er limen mellem hvert program. De forbinder de forskellige slutninger af værktøjerne med andre software. Du kan dele resultaterne af dine visualiseringsværktøjer direkte på Facebook gennem disse værktøjer.

Der vil være tidspunkter i din datakarriere, hvor et værktøj simpelthen ikke vil skære det. Mens nutidens værktøjer bliver mere kraftfulde og nemmere at bruge, er det nogle gange bare bedre at kode det selv. Der er forskellige sprog, der hjælper dig med forskellige aspekter som statistisk databehandling og grafik. Disse sprog kunne fungere som et supplement til datamining og statistiske software.

De vigtigste ting at huske i design af Big Data Architecture er:

Jeg ved, at du ville tænke på forskellige værktøjer, du kan bruge til at lave en fuldsikker Big Data-løsning. Nå, i mine kommende indlæg om Big Data vil jeg dække nogle bedste værktøjer til at opnå forskellige opgaver i big data-arkitektur .

Kunstig intelligens er ikke i fremtiden, det er her lige i nuet I denne blog Læs, hvordan kunstig intelligens-applikationer har påvirket forskellige sektorer.

Er du også et offer for DDOS-angreb og forvirret over forebyggelsesmetoderne? Læs denne artikel for at løse dine spørgsmål.

Du har måske hørt, at hackere tjener mange penge, men har du nogensinde spekuleret på, hvordan tjener de den slags penge? lad os diskutere.

Vil du se revolutionerende opfindelser fra Google, og hvordan disse opfindelser ændrede livet for ethvert menneske i dag? Læs derefter til bloggen for at se opfindelser fra Google.

Konceptet med selvkørende biler til at køre på vejene ved hjælp af kunstig intelligens er en drøm, vi har haft i et stykke tid nu. Men på trods af flere løfter er de ingen steder at se. Læs denne blog for at lære mere...

Efterhånden som videnskaben udvikler sig i et hurtigt tempo og overtager en stor del af vores indsats, stiger risikoen for at udsætte os selv for en uforklarlig Singularitet. Læs, hvad singularitet kunne betyde for os.

Opbevaringsmetoderne for dataene har været under udvikling, kan være siden fødslen af dataene. Denne blog dækker udviklingen af datalagring på basis af en infografik.

Læs bloggen for at kende forskellige lag i Big Data-arkitekturen og deres funktionaliteter på den enkleste måde.

I denne digitalt drevne verden er smarte hjemmeenheder blevet en afgørende del af livet. Her er et par fantastiske fordele ved smarte hjemmeenheder om, hvordan de gør vores liv værd at leve og enklere.

For nylig udgav Apple macOS Catalina 10.15.4 en supplerende opdatering for at løse problemer, men det ser ud til, at opdateringen forårsager flere problemer, hvilket fører til mursten af mac-maskiner. Læs denne artikel for at lære mere