Повстання машин: застосування ШІ в реальному світі

Штучний інтелект не в майбутньому, він тут прямо в сьогоденні У цьому блозі Прочитайте, як програми штучного інтелекту вплинули на різні сектори.

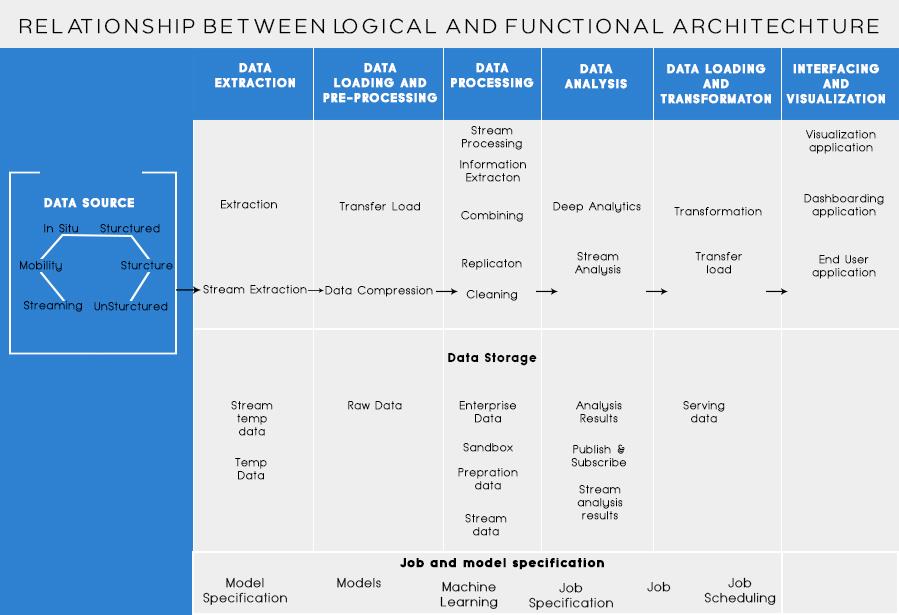

У моїй останній публікації ми обговорювали аналіз бізнес-проблеми та основні кроки для проектування архітектури великих даних. Сьогодні я збираюся розповісти про різні шари в архітектурі великих даних та їх функціональні можливості.

Логічні шари еталонної архітектури великих даних

Основна ідея архітектури великих даних полягає в тому, щоб задокументувати правильний фундамент архітектури, інфраструктури та додатків. Отже, це дає змогу підприємствам більш ефективно використовувати великі дані щодня.

Його створюють дизайнери/архітектори з великих даних, перш ніж фізично реалізувати рішення. Створення архітектури великих даних зазвичай вимагає розуміння бізнесу/організації та її потреб у великих даних. Як правило, архітектури великих даних окреслюють апаратні та програмні компоненти, необхідні для виконання рішення для великих даних. Документи архітектури великих даних можуть також описувати протоколи для обміну даними, інтеграції додатків та інформаційної безпеки.

Додаткова інформація: Посібник для початківців з аналізу великих даних

Це також передбачає взаємозв’язок і організацію існуючих ресурсів для обслуговування потреб великих даних.

Нижче наведено логічні рівні еталонної архітектури:

Профілювання джерела є одним з найважливіших кроків у виборі архітектури або великих даних. Це передбачає визначення різних систем джерел та їх класифікацію на основі їх природи та типу.

Моменти, які слід враховувати під час профілювання джерел даних:

Прийняття даних – це вилучення даних із вищезгаданих джерел. Ці дані зберігаються в сховищі, а потім трансформуються для подальшої обробки на ньому.

Моменти, які слід враховувати:

Потрібно вміти зберігати великі обсяги даних будь-якого типу і мати можливість масштабувати за потребою. Ми також повинні враховувати кількість операцій введення в секунду (IOPS), які він може забезпечити. Розподілена файлова система Hadoop є найбільш часто використовуваною системою зберігання даних у світі великих даних, інші — це сховища даних NoSQL — MongoDB, HBase, Cassandra тощо.

Що потрібно враховувати при плануванні методології зберігання:

Багаторазово зросла не тільки кількість даних, що зберігаються, але й обробка.

Раніше часто використовувані дані зберігалися в Dynamic RAM. Але тепер він зберігається на кількох дисках на кількох машинах, підключених через мережу через величезний обсяг. Тому замість того, щоб збирати фрагменти даних для обробки, модулі обробки передаються до великих даних. Таким чином, значно скорочується мережевий ввод-вивод. Методологія обробки визначається вимогами бізнесу. Він може бути класифікований на пакетний, у режимі реального часу або гібридний на основі SLA.

Цей рівень споживає вихід, наданий шаром обробки. Різні користувачі, такі як адміністратор, бізнес-користувачі, постачальники, партнери тощо, можуть використовувати дані в різному форматі. Вихідні дані аналізу можуть бути використані механізмом рекомендацій або бізнес-процеси можуть бути запущені на основі аналізу.

Різні форми споживання даних:

Читайте також: Великі дані: кошмар майбутнього?

Функціональні рівні архітектури великих даних:

Може бути ще один спосіб визначення архітектури, тобто через поділ функціональності. Але категорії функціональності можуть бути згруповані разом у логічний рівень еталонної архітектури, тому бажана архітектура, яка виконується за допомогою логічних шарів.

Розшарування на основі функціональних можливостей виглядає нижче:

Аналізуючи всі джерела, з яких організація отримує дані і які можуть допомогти організації у прийнятті майбутніх рішень, слід перерахувати в цій категорії. Перелічені тут джерела даних є незалежно від того, чи є дані структурованими, неструктурованими чи напівструктурованими.

Перш ніж ви зможете зберігати, аналізувати або візуалізувати свої дані, ви повинні мати деякі. Вилучення даних полягає в тому, щоб взяти щось неструктуроване, наприклад, веб-сторінку, і перетворити це на структуровану таблицю. Після того, як ви його структуруєте, ви можете маніпулювати ним різними способами, використовуючи інструменти, описані нижче, щоб знайти інформацію.

Основна потреба під час роботи з великими даними — подумати, як зберігати ці дані. Частково те, як великі дані отримали відмітку як «ВЕЛИКІ», полягає в тому, що традиційні системи стали занадто великими для обробки. Хороший постачальник сховища даних повинен запропонувати вам інфраструктуру для запуску всіх інших інструментів аналітики, а також місце для зберігання та запиту ваших даних.

Попередній необхідний крок, перш ніж ми фактично почнемо добувати дані для розуміння. Завжди корисно створити чистий, добре структурований набір даних. Набори даних можуть бути будь-яких форм і розмірів, особливо якщо вони надходять з Інтернету. Виберіть інструмент відповідно до ваших вимог до даних.

Інтелектуальний аналіз даних — це процес виявлення інформації в базі даних. Метою аналізу даних є прийняття рішень і передбачення даних, які є у вас під рукою. Виберіть програмне забезпечення, яке дає вам найкращі прогнози для всіх типів даних і дозволяє створювати власні алгоритми для видобутку даних.

У той час як інтелектуальний аналіз даних полягає в тому, щоб просіяти ваші дані в пошуках раніше нерозпізнаних закономірностей, аналіз даних полягає в тому, щоб розбити ці дані та оцінити вплив цих закономірностей понаднормово. Аналітика — це постановка конкретних запитань і пошук відповідей у даних. Ви навіть можете задати питання про те, що буде в майбутньому!

Візуалізації – це яскравий і простий спосіб передати складні дані. І найкраще те, що більшість із них не вимагають кодування. Компанії з візуалізації даних оживлять ваші дані. Частина завдання для будь-якого вченого з даних полягає в тому, щоб передати інформацію з цих даних решті вашої компанії. Інструменти можуть допомогти вам створювати діаграми, карти та іншу подібну графіку на основі ваших даних.

Платформи інтеграції даних є сполучною ланкою між кожною програмою. Вони пов’язують різні висновки інструментів з іншим програмним забезпеченням. Ви можете поділитися результатами своїх інструментів візуалізації безпосередньо на Facebook за допомогою цих інструментів.

У вашій кар’єрі даних будуть випадки, коли інструмент просто не зможе їх обрізати. Хоча сьогоднішні інструменти стають потужнішими та простішими у використанні, іноді просто краще закодувати їх самостійно. Існують різні мови, які допомагають вам у різних аспектах, як-от статистичні обчислення та графіка. Ці мови можуть працювати як доповнення до програмного забезпечення для аналізу даних та статистичних даних.

Головне, що потрібно пам’ятати при розробці архітектури великих даних:

Я знаю, що ви подумаєте про різні інструменти, які можна використовувати для створення повноцінного рішення для великих даних. Що ж, у своїх майбутніх публікаціях про великі дані я розповім про деякі найкращі інструменти для досягнення різних завдань в архітектурі великих даних .

Штучний інтелект не в майбутньому, він тут прямо в сьогоденні У цьому блозі Прочитайте, як програми штучного інтелекту вплинули на різні сектори.

Ви також стали жертвою DDOS-атак і спантеличені методами запобігання? Прочитайте цю статтю, щоб вирішити свої запитання.

Можливо, ви чули, що хакери заробляють багато грошей, але чи замислювалися ви коли-небудь, як вони заробляють такі гроші? давайте обговоримо.

Ви хочете побачити революційні винаходи Google і як ці винаходи змінили життя кожної людини сьогодні? Тоді читайте в блозі, щоб побачити винаходи Google.

Концепція самокерованих автомобілів, щоб вирушати в дороги за допомогою штучного інтелекту, є мрією, яку ми давно мріємо. Але, незважаючи на кілька обіцянок, їх ніде не видно. Прочитайте цей блог, щоб дізнатися більше…

Оскільки наука розвивається швидкими темпами, бере на себе багато наших зусиль, ризики піддати себе незрозумілій Сингулярності також зростає. Читайте, що може означати для нас сингулярність.

Методи зберігання даних можуть розвиватися з моменту народження Даних. Цей блог висвітлює еволюцію зберігання даних на основі інфографіки.

Прочитайте блог, щоб дізнатися про різні шари архітектури великих даних та їх функціональні можливості найпростішим способом.

У цьому цифровому світі пристрої розумного дому стали важливою частиною життя. Ось кілька дивовижних переваг пристроїв розумного дому щодо того, як вони роблять наше життя гідним життя та спрощують його.

Нещодавно Apple випустила додаткове оновлення macOS Catalina 10.15.4, щоб виправити проблеми, але схоже, що оновлення викликає більше проблем, що призводять до блокування комп’ютерів Mac. Прочитайте цю статтю, щоб дізнатися більше