En el meu últim post , vam parlar sobre l'anàlisi del problema empresarial i els passos bàsics per dissenyar l'Arquitectura de Big Data. Avui parlaré de les diferents capes de l'Arquitectura de Big Data i les seves funcionalitats.

Capes lògiques de l'arquitectura de referència de Big Data

Darrere de l'arquitectura de big data, la idea bàsica és documentar una base adequada d'arquitectura, infraestructura i aplicacions. En conseqüència, això permet a les empreses utilitzar el big data de manera més eficaç cada dia.

Està creat per dissenyadors/arquitectes de big data abans d'implementar físicament una solució. La creació d'una arquitectura de big data requereix en general entendre l'empresa/organització i les seves necessitats de big data. Normalment, les arquitectures de big data descriuen els components de maquinari i programari que són necessaris per complir la solució de big data. Els documents d'arquitectura de grans dades també poden descriure protocols per compartir dades, integracions d'aplicacions i seguretat de la informació.

Més informació: una guia per a principiants a l'anàlisi de dades massives

També implica interconnectar i organitzar els recursos existents per atendre les necessitats de big data.

Les capes lògiques de l'arquitectura de referència són les següents:

- Identificació de la font de dades: saber d'on provenen aquestes dades.

El perfil d'origen és un dels passos més importants per decidir l'arquitectura o el big data. Implica identificar diferents sistemes font i categoritzar-los, en funció de la seva naturalesa i tipus.

Aspectes a tenir en compte a l'hora d'elaborar el perfil de les fonts de dades:

- Identificar sistemes de fonts internes i externes.

- Hipòtesi d'alt nivell per a la quantitat de dades ingerides de cada font

- Identifiqueu el mecanisme utilitzat per obtenir dades: push o pull

- Determineu el tipus de font de dades: base de dades, fitxer, servei web, fluxos, etc.

- Determineu el tipus de dades: estructurades, semiestructurades o no estructurades

- Estratègia i adquisició d'ingestió de dades : procés per introduir dades al sistema.

La ingestió de dades es refereix a l'extracció de dades de les fonts esmentades anteriorment. Aquestes dades s'emmagatzemen a l'emmagatzematge i després es transformen per a un posterior processament.

Punts a tenir en compte:

- Determineu la freqüència amb què s'ingereixen les dades de cada font

- Cal canviar la semàntica de les dades?

- Es requereix alguna validació o transformació de dades abans de la ingestió (processament previ)?

- Separeu les fonts de dades segons el mode d'ingestió: per lots o en temps real

- Emmagatzematge de dades : la instal·lació on s'emmagatzemaran les grans dades.

Un hauria de ser capaç d'emmagatzemar grans quantitats de dades de qualsevol tipus i s'hauria de poder escalar segons les necessitats. També hem de tenir en compte el nombre d'IOPS (operacions d'entrada de sortida per segon) que pot proporcionar. El sistema de fitxers distribuïts Hadoop és el marc d'emmagatzematge més utilitzat al món de Big Data, altres són els magatzems de dades NoSQL: MongoDB, HBase, Cassandra, etc.

Coses a tenir en compte a l'hora de planificar la metodologia d'emmagatzematge:

- Tipus de dades (històrics o incrementals)

- Format de les dades (estructurades, semiestructurades i no estructurades)

- Requisits de compressió

- Freqüència d'entrada de dades

- Patró de consulta a les dades

- Consumidors de les dades

- Processament de dades : eines que proporcionen anàlisi sobre big data.

No només la quantitat de dades que s'emmagatzemen, sinó que el processament també s'ha multiplicat.

Les dades d'accés freqüent anteriors s'emmagatzemaven a RAM dinàmiques. Però ara, s'emmagatzema en diversos discs en diverses màquines connectades mitjançant xarxa a causa del gran volum. Per tant, en comptes de reunir fragments de dades per processar-los, els mòduls de processament es porten al big data. Així, es redueix significativament l'E/S de xarxa. La metodologia de processament es basa en els requisits empresarials. Es pot classificar en lots, en temps real o híbrid segons el SLA.

- Processament per lots : el lot està recopilant l'entrada durant un interval de temps especificat i executant-hi transformacions de manera programada. La càrrega de dades històriques és una operació per lots típica

- Processament en temps real: el processament en temps real implica executar transformacions a mesura que s'adquireixen les dades.

- Processament híbrid : és una combinació de necessitats de processament per lots i en temps real.

- Consum/utilització de dades : Usuaris/serveis que utilitzen les dades analitzades.

Aquesta capa consumeix la sortida proporcionada per la capa de processament. Diferents usuaris com administradors, usuaris empresarials, venedors, socis, etc. poden consumir dades en diferents formats. La sortida de l'anàlisi es pot consumir pel motor de recomanacions o els processos de negoci es poden activar en funció de l'anàlisi.

Les diferents formes de consum de dades són:

- Exporta conjunts de dades : hi pot haver requisits per a la generació de conjunts de dades de tercers. Els conjunts de dades es poden generar mitjançant l'exportació de rusc o directament des de HDFS.

- Informes i visualització : diferents escanejos d'eines d'informes i visualització es connecten a Hadoop mitjançant la connectivitat JDBC/ODBC per al rusc.

- Exploració de dades: el científic de dades pot crear models i realitzar una exploració profunda en un entorn de sandbox. Sandbox pot ser un clúster separat (enfocament recomanat) o un esquema separat dins del mateix clúster que conté un subconjunt de dades reals.

- Consulta adhoc : es pot donar suport a la consulta adhoc o interactiva mitjançant Hive, Impala o spark SQL.

Llegiu també: Big Data: un malson futur?

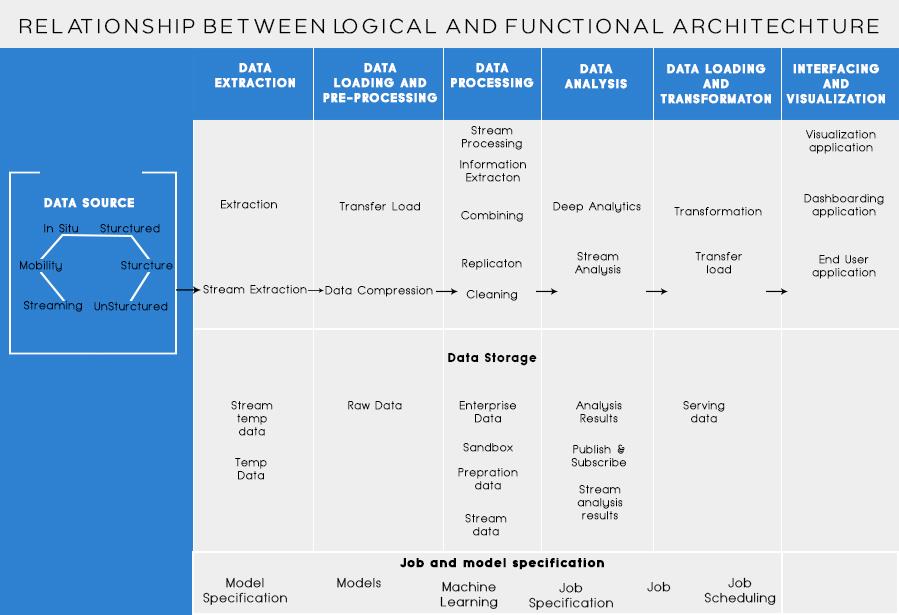

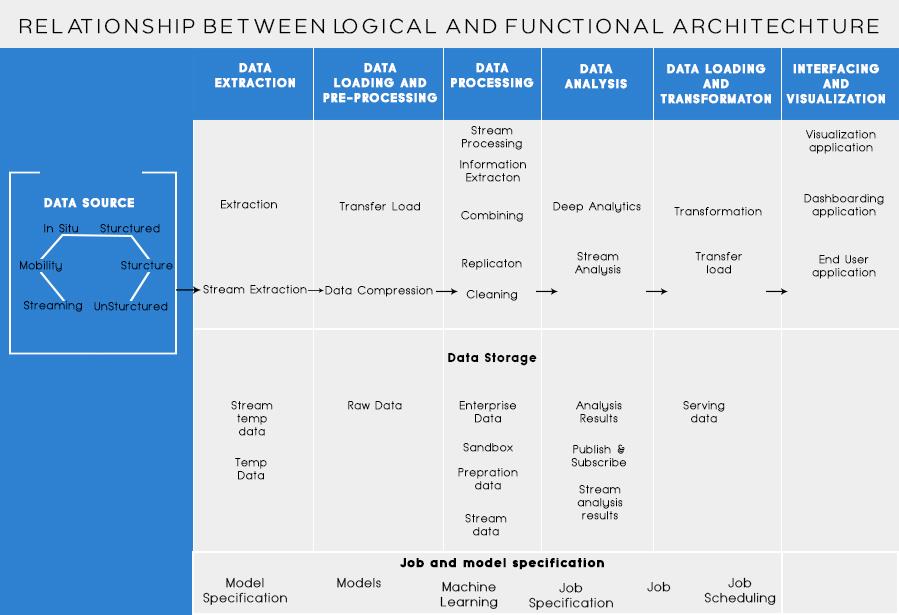

Capes funcionals de l'arquitectura de Big Data:

Hi podria haver una manera més de definir l'arquitectura, és a dir, mitjançant la divisió de funcionalitats. Però les categories de funcionalitats es podrien agrupar en la capa lògica de l'arquitectura de referència, per tant, l'Arquitectura preferida és la que es fa amb capes lògiques.

La superposició basada en les funcionalitats és la següent:

- Fonts de dades:

En aquesta categoria s'han d'analitzar totes les fonts de les quals una organització rep les dades i que podrien ajudar l'organització a prendre decisions futures. Les fonts de dades enumerades aquí són independentment de si les dades estan estructurades, no estructurades o semiestructurades.

- Extracció de dades:

Abans de poder emmagatzemar, analitzar o visualitzar les vostres dades, n'heu de tenir-ne. L'extracció de dades consisteix a agafar quelcom que no està estructurat, com ara una pàgina web, i convertir-lo en una taula estructurada. Un cop el tingueu estructurat, podeu manipular-lo de tota mena de maneres, utilitzant les eines que es descriuen a continuació, per trobar informació.

- Emmagatzematge de dades:

La necessitat bàsica mentre es treballa amb big data és pensar com emmagatzemar aquestes dades. Part de com Big Data va obtenir la distinció com a "BIG" és que es va convertir en massa per als sistemes tradicionals. Un bon proveïdor d'emmagatzematge de dades us hauria d'oferir una infraestructura on executar totes les altres eines d'anàlisi, així com un lloc per emmagatzemar i consultar les vostres dades.

- Neteja de dades:

Un pas previ necessari abans de començar a extreure les dades per obtenir informació. Sempre és una bona pràctica crear un conjunt de dades net i ben estructurat. Els conjunts de dades poden tenir totes les formes i mides, especialment quan provenen del web. Trieu una eina segons els vostres requisits de dades.

- Mineria de dades:

La mineria de dades és el procés de descobrir coneixements dins d'una base de dades. L'objectiu de la mineria de dades és prendre decisions i prediccions sobre les dades que teniu a mà. Trieu un programari que us ofereixi les millors prediccions per a tot tipus de dades i us permeti crear els vostres propis algorismes per extreure les dades.

- Analítica de dades:

Tot i que la mineria de dades consisteix a examinar les vostres dades a la recerca de patrons no reconeguts anteriorment, l'anàlisi de dades consisteix a desglossar aquestes dades i avaluar l'impacte d'aquests patrons amb el temps. L'anàlisi consisteix a fer preguntes específiques i trobar les respostes a les dades. Fins i tot podeu fer preguntes sobre què passarà en el futur!

- Visualització de dades:

Les visualitzacions són una manera brillant i senzilla de transmetre informació complexa de dades. I la millor part és que la majoria d'ells no requereixen codificació. Les empreses de visualització de dades faran que les vostres dades cobren vida. Part del repte per a qualsevol científic de dades és transmetre la informació d'aquestes dades a la resta de la vostra empresa. Les eines us poden ajudar a crear gràfics, mapes i altres gràfics a partir de les vostres dades.

- Integració de dades:

Les plataformes d'integració de dades són la cola entre cada programa. Connecten les diferents inferències de les eines amb altres programaris. Podeu compartir els resultats de les vostres eines de visualització directament a Facebook mitjançant aquestes eines.

- Idiomes de dades:

Hi haurà moments en la vostra carrera de dades en què una eina simplement no la tallarà. Tot i que les eines actuals són cada cop més potents i fàcils d'utilitzar, de vegades és millor codificar-les tu mateix. Hi ha diferents idiomes que us ajuden en diferents aspectes com la informàtica estadística i els gràfics. Aquests llenguatges podrien funcionar com a complement per a la mineria de dades i els programaris estadístics.

Els aspectes clau a recordar en el disseny de l'arquitectura de Big Data són:

- Dinàmica d'ús : hi ha una sèrie d'escenaris, tal com s'il·lustra a l'article, que cal tenir en compte a l'hora de dissenyar l'arquitectura: forma i freqüència de les dades, tipus de dades, tipus de processament i anàlisi necessaris.

- Infinitat de tecnologies: la proliferació d'eines al mercat ha generat molta confusió sobre què utilitzar i quan, hi ha diverses tecnologies que ofereixen funcions similars i que afirmen ser millors que les altres.

Sé que estaries pensant en diferents eines per utilitzar per fer una solució de Big Data a prova completa. Bé, a les meves properes publicacions sobre Big Data, cobriria algunes de les millors eines per aconseguir diferents tasques en l'arquitectura de Big Data .