Възходът на машините: Реални приложения на AI

Изкуственият интелект не е в бъдещето, тук е точно в настоящето. В този блог Прочетете как приложенията за изкуствен интелект са повлияли на различни сектори.

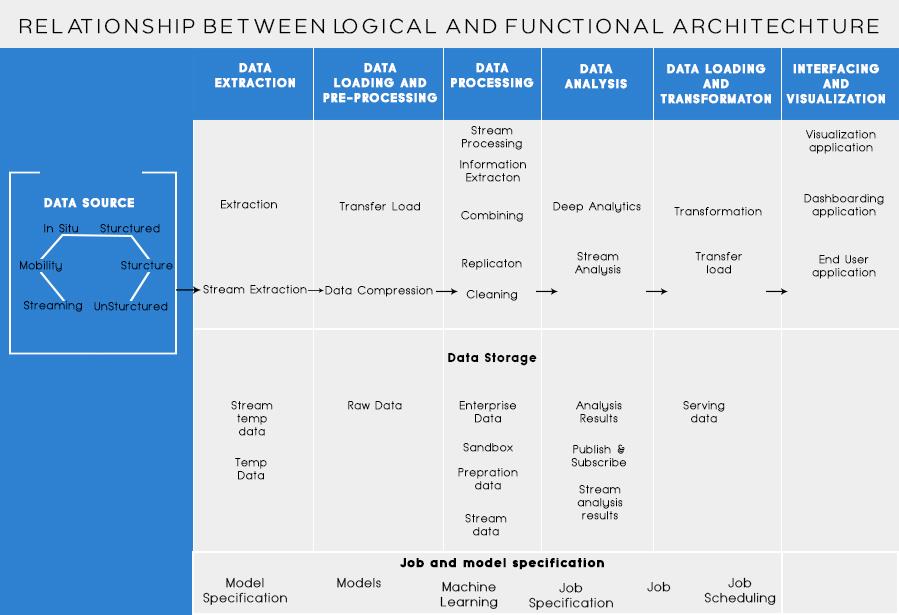

В последната ми публикация обсъдихме анализирането на бизнес проблема и основните стъпки за проектиране на архитектурата на големи данни. Днес ще говоря за различните слоеве в архитектурата на големите данни и техните функционалности.

Логически слоеве на референтната архитектура за големи данни

Зад архитектурата за големи данни основната идея е да се документира правилната основа на архитектура, инфраструктура и приложения. Следователно това позволява на бизнеса да използва по-ефективно големи данни в ежедневието.

Създава се от дизайнери/архитекти на големи данни преди физическото прилагане на решение. Създаването на архитектура за големи данни обикновено изисква разбиране на бизнеса/организацията и нейните нужди от големи данни. Обикновено архитектурите за големи данни очертават хардуерните и софтуерните компоненти, които са необходими за изпълнение на решението за големи данни. Документите за архитектура на големи данни могат също да описват протоколи за споделяне на данни, интеграция на приложения и информационна сигурност.

Повече информация: Ръководство за начинаещи за анализ на големи данни

Това също така включва взаимно свързване и организиране на съществуващи ресурси за обслужване на нуждите от големи данни.

Логическите слоеве на референтната архитектура са както следва:

Профилирането на източника е една от най-важните стъпки при вземането на решение за архитектурата или големите данни. Това включва идентифициране на различни изходни системи и категоризирането им въз основа на тяхното естество и тип.

Точки, които трябва да се вземат предвид при профилиране на източници на данни:

Поглъщането на данни е свързано с извличането на данните от гореспоменатите източници. Тези данни се съхраняват в хранилището и след това се трансформират за по-нататъшна обработка върху него.

Точки, които трябва да се вземат предвид:

Човек трябва да може да съхранява големи количества данни от всякакъв тип и трябва да може да мащабира според нуждите. Трябва също да вземем предвид броя на IOPS (входни изходни операции в секунда), които може да осигури. Разпределената файлова система Hadoop е най-често използваната рамка за съхранение в света на големите данни, други са хранилищата на данни NoSQL - MongoDB, HBase, Cassandra и др.

Неща, които трябва да имате предвид, когато планирате методологията за съхранение:

Не само количеството съхранявани данни, но и обработката се е увеличила многократно.

По-рано често достъпните данни се съхраняваха в динамични RAM памети. Но сега той се съхранява на множество дискове на редица машини, свързани чрез мрежа, поради големия обем. Следователно, вместо да събират парчета данни за обработка, модулите за обработка се отвеждат към големите данни. По този начин значително намаляване на мрежовия I/O. Методологията за обработка се ръководи от бизнес изискванията. Тя може да бъде категоризирана в пакетна, в реално време или хибридна въз основа на SLA.

Този слой консумира продукция, предоставена от обработващия слой. Различни потребители като администратор, бизнес потребители, доставчик, партньори и т.н. могат да консумират данни в различен формат. Резултатът от анализа може да бъде използван от препоръчителната машина или бизнес процеси могат да бъдат задействани въз основа на анализа.

Различните форми на потребление на данни са:

Прочетете също: Големите данни: бъдещ кошмар?

Функционални слоеве на архитектурата на големите данни:

Може да има още един начин за дефиниране на архитектурата, т.е. чрез разделението на функционалността. Но категориите за функционалност могат да бъдат групирани заедно в логическия слой на референтната архитектура, така че предпочитаната архитектура е тази, извършена с помощта на логически слоеве.

Наслояването въз основа на функционалностите е както следва:

Анализирането на всички източници, от които една организация получава данни и които биха могли да помогнат на организацията при вземането на бъдещи решения, трябва да бъде изброено в тази категория. Източниците на данни, изброени тук, са независимо дали данните са структурирани, неструктурирани или полуструктурирани.

Преди да можете да съхранявате, анализирате или визуализирате вашите данни, трябва да имате някои. Извличането на данни е свързано с вземането на нещо, което е неструктурирано, като уеб страница, и превръщането му в структурирана таблица. След като го структурирате, можете да го манипулирате по всякакви начини, като използвате инструментите, описани по-долу, за да намерите прозрения.

Основната необходимост, докато работите с големи данни, е да мислите как да съхранявате тези данни. Част от това как Big Data получиха разликата като „ГОЛЕМИ“ е, че станаха твърде много за традиционните системи, за да се справят. Добрият доставчик на съхранение на данни трябва да ви предложи инфраструктура, върху която да изпълнявате всичките си други инструменти за анализ, както и място за съхранение и запитване на вашите данни.

Предварително необходима стъпка, преди всъщност да започнем да копаем данните за прозрения. Винаги е добра практика да се създаде чист, добре структуриран набор от данни. Наборите от данни могат да се предлагат във всякакви форми и размери, особено когато идват от мрежата. Изберете инструмент според вашите изисквания за данни.

Извличането на данни е процесът на откриване на прозрения в база данни. Целта на извличането на данни е да се вземат решения и прогнози върху данните, които имате под ръка. Изберете софтуер, който ви дава най-добрите прогнози за всички видове данни и ви позволява да създавате свои собствени алгоритми за копаене на данните.

Докато извличането на данни е свързано с пресяване на вашите данни в търсене на неразпознати по-рано модели, анализът на данните е за разбиване на тези данни и оценка на въздействието на тези модели извънредно време. Анализът е свързан с задаването на конкретни въпроси и намирането на отговорите в данните. Можете дори да задавате въпроси за това какво ще се случи в бъдеще!

Визуализациите са ярък и лесен начин за предаване на сложни данни. И най-хубавото е, че повечето от тях не изискват кодиране. Компаниите за визуализация на данни ще оживеят вашите данни. Част от предизвикателството за всеки учен по данни е да предаде прозренията от тези данни на останалата част от вашата компания. Инструментите могат да ви помогнат да създавате диаграми, карти и други подобни графики от вашите данни.

Платформите за интегриране на данни са лепилото между всяка програма. Те свързват различните изводи на инструментите с други софтуери. Можете да споделите резултатите от вашите инструменти за визуализация директно във Facebook чрез тези инструменти.

Ще има моменти във вашата кариера с данни, когато инструмент просто няма да го отреже. Докато днешните инструменти стават все по-мощни и по-лесни за използване, понякога е по-добре да ги кодирате сами. Има различни езици, които ви помагат в различни аспекти като статистически изчисления и графики. Тези езици могат да работят като допълнение към софтуера за извличане на данни и статистически софтуер.

Основното нещо, което трябва да запомните при проектирането на архитектура на големи данни, са:

Знам, че ще мислите за различни инструменти, които да използвате, за да създадете пълно доказателство за решение за големи данни. Е, в предстоящите си публикации за Big Data ще разгледам някои най-добри инструменти за постигане на различни задачи в архитектурата на големи данни .

Изкуственият интелект не е в бъдещето, тук е точно в настоящето. В този блог Прочетете как приложенията за изкуствен интелект са повлияли на различни сектори.

Вие също сте жертва на DDOS атаки и сте объркани относно методите за превенция? Прочетете тази статия, за да разрешите вашите запитвания.

Може би сте чували, че хакерите печелят много пари, но чудили ли сте се някога как печелят такива пари? нека обсъдим.

Искате ли да видите революционни изобретения на Google и как тези изобретения промениха живота на всяко човешко същество днес? След това прочетете в блога, за да видите изобретенията на Google.

Концепцията за самоуправляващи се автомобили да тръгват по пътищата с помощта на изкуствен интелект е мечта, която имаме от известно време. Но въпреки няколкото обещания, те не се виждат никъде. Прочетете този блог, за да научите повече…

Тъй като науката се развива с бързи темпове, поемайки много от нашите усилия, рискът да се подложим на необяснима сингулярност също нараства. Прочетете какво може да означава сингулярността за нас.

Методите за съхранение на данните може да се развиват от раждането на данните. Този блог обхваща развитието на съхранението на данни на базата на инфографика.

Прочетете блога, за да разберете различни слоеве в архитектурата на големи данни и техните функционалности по най-простия начин.

В този дигитално задвижван свят устройствата за интелигентен дом се превърнаха в решаваща част от живота. Ето няколко невероятни предимства на интелигентните домашни устройства за това как те правят живота ни струващ и по-опростен.

Наскоро Apple пусна macOS Catalina 10.15.4 допълнителна актуализация за отстраняване на проблеми, но изглежда, че актуализацията причинява повече проблеми, водещи до блокиране на mac машини. Прочетете тази статия, за да научите повече