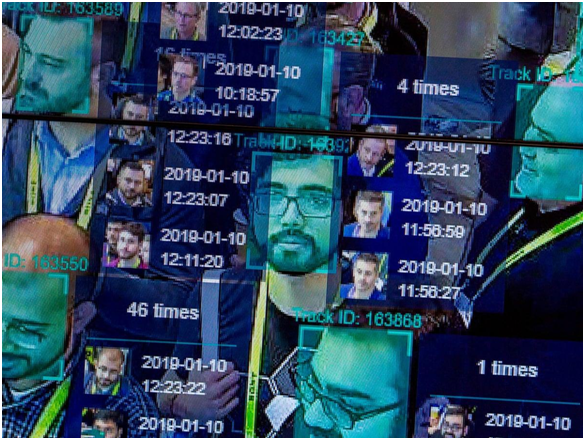

Tehnologija prepoznavanja obrazov in njene zmožnosti so daleč presegle našo domišljijo, odkar so se pojavili novi algoritmi za krepitev te tehnologije v kazenskem pregonu. Trenutno tehnologijo za prepoznavanje obrazov uporabljajo organi pregona na najnižjih ravneh procesov zbiranja podatkov za identifikacijo storilcev kaznivih dejanj med množičnimi zbiranji. Tehnika uporablja posnetke s kamer CCTV na javnih mestih in ulicah, nato pa zbrane podatke požene proti arhivu agencije, da odkrije obraz, ki ga iščejo zaradi kaznivih dejanj.

Ta tehnologija je bila nadalje vgrajena v najmanjše pripomočke, vključno z mobilnimi telefoni in pametnimi nosljivimi napravami. Zato vas ne ščiti le na ulicah, ampak namerava zaščititi tudi vaše osebne podatke, shranjene v vaših pametnih napravah. Uporaba "faceprinta" za marketinške in oglaševalske prakse je postala običajna v sodobni dobi kampanj na družbenih medijih. In potem je zasebni nadzor v nakupovalnih centrih, maloprodajnih trgovinah itd.

S tega vidika lahko hitro izpostavimo nesporne prednosti tehnologije prepoznavanja obraza. Vendar je bil pod drobnogledom tudi zaradi grožnje, ki jo predstavlja za zasebnost uporabnikov, varstvo podatkov in seveda preglednost med zakonom in javnostjo. Dobro se je zavedati prednosti in slabosti takšne invazivne tehnologije. Vendar pa obstaja še ena pomanjkljivost tehnologije za prepoznavanje obrazov, ki jo ljudje prezrejo, in to je rasno profiliranje in rasna diskriminacija .

V tem delu si ogledamo, kako ta tehnologija spodbuja rasno pristranskost in diskriminacijo ter kako resne so posledice takšne invazivne tehnologije.

Kako deluje prepoznavanje obrazov?

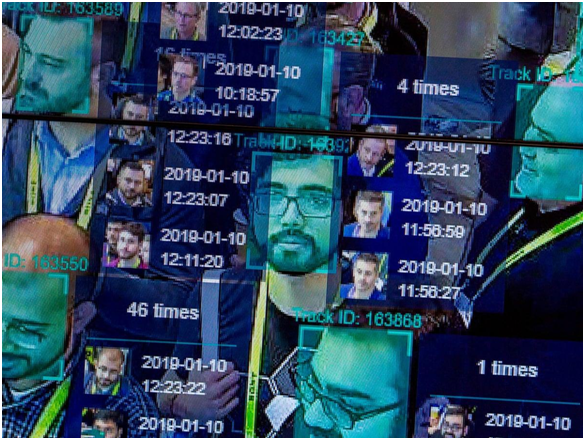

Vir slike: National Post

1. korak: vaša slika je posneta s fotoaparata, vašega računa, e-pošte itd. To je bodisi ravna profilna slika ali naključni posnetek v množici.

2. korak: Programska oprema za prepoznavanje obrazov bo zagnala vaš obraz skozi bazo podatkov shranjenih obraznih odtisov. Odtis obraza se zbira z geometrijskim sledenjem vašega obraza.

3. korak: Odstotek ujemanja vaše slike s katerim koli znanim odtisom obraza se ustvari z uporabo algoritma, na podlagi katerega se določi.

Pristranskost avtomatizacije: ena od mnogih pomanjkljivosti tehnologije za prepoznavanje obrazov

Pristranskost avtomatizacije ali pristranskost stroja se nanaša na scenarij, kjer strojni algoritem kaže določeno pristranskost pri kalibraciji vhodnih podatkov, kar daje neugoden rezultat. To se zgodi, ko pride do napake v kodi algoritma, pomanjkanja shranjenih podatkovnih nizov za kalibracijo, napačnih vhodnih vrednosti ali prevelikih vhodnih podatkov, ki jih stroji ne morejo umeriti.

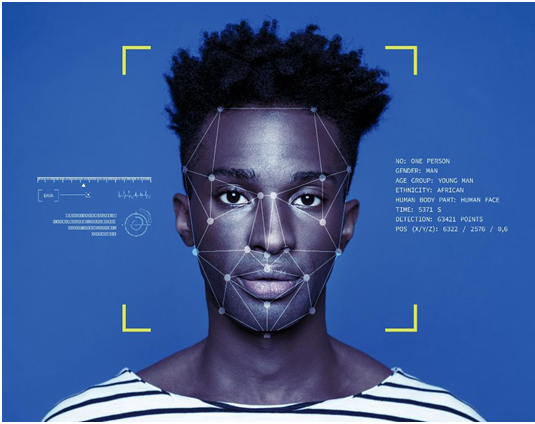

Kako je rasno profiliranje z vsem tem?

Vir slike: The Guardian

Začnimo s starodavnim incidentom, ki je takrat veljal za nepomemben. Leta 2001 je Tampa City uporabil programsko opremo za prepoznavanje obrazov za nadzor nad prenatrpanim mestom, ko so turisti preplavili mestne ulice zaradi Super Bowla leta 2001. Glede na poročilo New York Timesa je programska oprema identificirala 19 ljudi, ki naj bi imeli zoper njih neporavnane naloge; vendar aretacije niso bile izvedene, saj je infrastruktura stadiona onemogočala priti do ugotovljenih krivcev med ogromno množico.

Čeprav znaki rasnega profiliranja v tem konkretnem primeru niso bili nikjer zasledeni, je bilo to prvič, da so bile tehnike nadzora uvedene proti kršitvi državljanskih svoboščin in zasebnosti posameznikov. V prihodnjih letih je policija Tampe opustila te nadzorne sisteme in se sklicevala na nezanesljive rezultate.

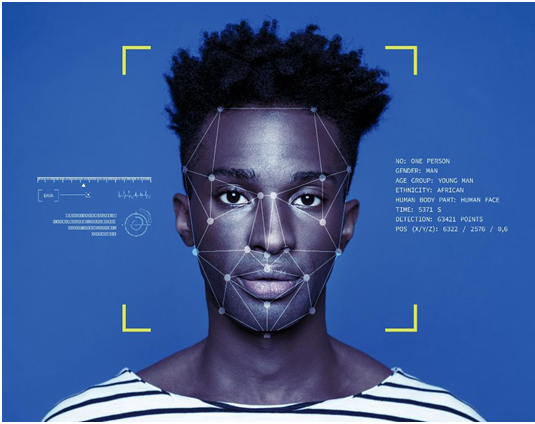

Vir slike: ICO

Po hitrem napredovanju na nekoliko novejši scenarij je Ali Breland za The Guardian poročal o aretaciji Willieja Lyncha, temnopoltega moškega, obtoženega, da je zloglasni preprodajalec mamil na območju Brentwooda, ki je pretežno soseska barvnih ljudi. Edini dokaz proti Lynchu so bile njegove slike na mobilnem telefonu, ki so bile pregledane v policijski bazi podatkov, preden ga je policija ugotovila kot krivca. Lynch je bil obsojen na osem let, zdaj pa se je zoper obsodbo pritožil. Ne glede na to, ali je bil domnevni preprodajalec ali ne, neizogibno vzbuja zaskrbljenost, ali je samo rezultat, ki temelji na stroju, dovolj, da se potrdi obsodba kogar koli v preiskavi?

Leta 2019, kot je poročal Tom Perkins za The Guardian , so ugotovili, da je policija v Detroitu uporabljala prepoznavanje obrazov za aretacije domnevno v zadnjih dveh letih. Detroit je kraj, kjer je več kot 80 % prebivalstva temnopoltih. Izjava temnopoltega člana iz policijske komisije v Detroitu je vzbujala zaskrbljenost glede te prakse. Dejal je, da imajo temnopolti ljudje skupno lastnost obraza, ki ogroža sistemski algoritem, in to označil za "tehno-rasizem".

Vir slike: Vox

V raziskavi iz leta 2019 za revijo Journal of Information Communication and Ethics Society, ki sta jo opravila Fabio Bacchini in Ludovica Lorusso, je bilo ugotovljeno, da ti biometrični sistemi in sistemi za prepoznavanje obrazov niso 100-odstotno zanesljivi za organe pregona. Poleg tega je rasna diskriminacija negativno vplivala na vse takšne sisteme, kar ima nadaljnje inverzne družbene posledice. Študija je bila namenjena zlasti zahodnim družbam, kjer se takšni sistemi obsežno uporabljajo za nadzor.

To so le trije od mnogih takšnih primerov, ko so se pojavile rasne razlike, ki jih povzročajo sistemi za prepoznavanje obrazov. Toda zakaj so ti sistemi tako nesposobni kljub vse večji natančnosti pri nadgradnjah algoritemskega kodiranja v tehnologiji.

Nadmoč bele v zahodnih državah: tehnološka industrija, ki prevladuje v belih

Leta 2014 je bilo ugotovljeno, da večina tehnoloških podjetij, vključno z velikanom Apple Inc., zaposluje večinoma bele moške zaposlene. V Applu je bilo 55 % zaposlenih belcev, podobno pa je Apple vodstvo obsegalo 63 % belih zaposlenih. Podjetja, ki so delila podobna poročila o raznolikosti, so tudi Facebook , Google in Twitter. Pet let pozneje je poročilo v Wiredu razkrilo, da je prišlo do minimalnega izboljšanja teh številk.

Medtem ko je Facebook pokazal dostojno izboljšanje številk, je bil odstotek Applovih temnopoltih tehničnih delavcev nespremenjen in znaša le 6 % celotne delovne sile. Amazon je bil edina organizacija, ki je v svojih pisarnah v ZDA registrirala 42 % črnih ali latinskoameriških delavcev.

Kaj pomenijo te statistike? V ZDA je večina koderjev, ki so dodeljeni večjim projektom, kot je oblikovanje algoritmov za nadzorne sisteme, belih. To so ljudje, ki sprejemajo najpomembnejše odločitve v zvezi z izdelkom ali storitvijo, ki naj bi jo lansiralo/razkrilo podjetje. In zato so njihove perspektive, pristop in miselni procesi tisti, ki gredo v končno kreacijo. To ne pomeni, da so belci rasisti in so namenoma zasnovali takšne sisteme nadzora . NE!

Vir slike: Forbes

Ko belec oblikuje algoritem za prepoznavanje obrazov in mu svetujejo/pomagajo samo belci, ne upoštevajo obraznih lastnosti ljudi druge barve, preden dokončajo kodo. Ker beli inženirji prevladujejo v tehnološki industriji, arhive podatkov, ki se uporabljajo za pripravo začetne kode, prav tako ustvarijo in kalibrirajo beli tehniki. Tako je sama koda ustvarjena s pristranskostjo v svojem osrednjem kalkulativnem algoritmu, kar ima za posledico te rasne razlike v rezultatih nadzora.

Koda se preprosto nauči, kaj v njej poosebljajo belci. Ni perspektive ali prispevka katere koli osebe druge barve.

Težave s kalibracijo

Ameriški organi pregona se močno zanašajo na nadzor in sledenje podatkov. Bilo je veliko primerov, ko so žvižgači izrinili informacije o nepooblaščenem nadzoru civilistov. Eden takšnih primerov je razkritje Edwarda Snowdena o nezakonitem nadzoru NSA.

Vir slike: CBS Local

Te nadzorne programe podpirajo odtisi obraza in drugi osebni podatki milijonov državljanov. Če upoštevamo samo odtise obraza, je na milijone Američanov, ki odkrito delijo slike na platformah družbenih medijev. Potem so v vsaki ulici v državi nameščene CCTV kamere, ki ponujajo žive posnetke sto tisoč mimoidočih. Trenutno je v policijskih bazah podatkov približno 117 milijonov slik, medtem ko ima FBI več kot 400 milijonov podatkovnih nizov za kalibracijo v algoritmih za prepoznavanje obrazov za nadzor.

Zdaj si predstavljajte, da te nabore podatkov primerjate z eno samo sliko, ki je lahko zajela vse obrazne poteze določene osebe ali pa tudi ne. V takem scenariju se lahko pojavijo napake. Podatkov je preprosto preveč, da bi jih razumeli in zagnali na enem obraznem odtisu. Noben algoritem ne more zagotoviti stoodstotnega zagotovila za svoj rezultat, ko je kalibracija tako zapletena. To sčasoma prispeva k rasnemu profiliranju, ki ga povzroča tehnologija za prepoznavanje obrazov.

Izjemna zanesljivost pri prepoznavanju obrazov

Vir slike: NY Post

Primer Willieja Lyncha je opomin, da prepoznavanje obrazov ne bi smelo biti edina zanesljiva tehnika, predstavljena kot dokaz, ko gre za kazenski pregon. To je razlog, da je mestna policija Tampe opustila tehnologijo.

Res je, da je prepoznavanje obrazov odlična rešitev in je v pomoč policiji. Krivce za bombne napade v Bostonu so prepoznali z obsežno in podrobno analizo nadzornih posnetkov. Toda to ne more biti edini dokaz, ki bi koga obsodil. Obstajati morajo podporni dokazi za dokazovanje rezultatov algoritmov za prepoznavanje obrazov, pred dokončno odločitvijo pa je treba razmisliti o konceptu pristranskosti avtomatizacije.

Težava s strojno opremo: prepoznavanje obrazov v mobilnih napravah in kamerah

Vir slike: TechCrunch

Sistemov nadzornih kamer ter pripadajoče strojne in programske opreme ni zasnovalo eno podjetje. To je industrija, vredna milijarde dolarjev, v kateri desetine korporacij tekmujejo za pridobitev pogodb od organov pregona. Veliko teh sistemov je kitajskih proizvajalcev. Gre za pridobitev najcenejše tehnologije z najboljšimi lastnostmi. Tako večinoma deluje. Zato vedno obstajajo možnosti za razlike v kalibraciji različnih sistemov, pa tudi za razlike v kakovosti rezultatov nadzora. Številni algoritmi za nadzor kamer so neučinkoviti pri umerjanju slik barvnih ljudi samo zaradi tehnične nesposobnosti in tako poveličujejo rasno diskriminacijo.

Tehnološke težave, ki povzročajo rasizem prek prepoznavanja obrazov, so bile opažene tudi v funkciji Apple Face Lock. Primer iz Kitajske je izrinil, da zaklepanje obraza iPhone X ni moglo razlikovati med dvema različnima kitajskima sodelavcema, zaradi česar je funkcija neuporabna. Podobna poročila so bila zavrnjena, saj so navedli težave pri ločevanju dveh temnopoltih ljudi drug od drugega. Kot je navedeno zgoraj, ima Apple le 6 % temnopoltih ljudi v tehničnih ekipah. To je jasen primer, kako lahko tehnologija za prepoznavanje obrazov spodbuja rasizem tudi v naših ročnih napravah.

Zaključek

Da, prepoznavanje obrazov je rasistično in to je zdaj splošno znano. Medtem ko tehnologija vsak dan raste, da bi odpravila takšne težave, so rezultati enaki. Tehnologija naj bi združila svet pri skupnih ciljih tehničnega napredka in razvoja, a nekatere tehnike le škodujejo rasni in skupni harmoniji.

Za zdaj je najboljše, kar lahko storijo organi pregona, da ne podprejo svojih primerov na podlagi dokazov iz algoritemskih kalibracij, ki niti niso zanesljive. Poleg tega je skrajni čas, da se raznolikost in vključenost na delovna mesta vzame resno, da se lahko ljudje vseh etničnih skupin združijo in ustvarijo izdelek brez rasnih razlik. Na svetu je na tisoče ras in ljudje so zrasli, da so pustili ob strani rasne razlike, ki so tako dolgo preganjale svetovno družbo. Če je treba to ohraniti, je treba enako učiti tudi stroje, na katere se tako zelo zanašamo.